AIsuru vs Copilot Studio vs Bedrock Agent Maker vs OpenAI GPTs

Di seguito viene presentato un confronto dettagliato dei quattro strumenti lungo i principali criteri indicati. Vengono evidenziati i punti di forza di AIsuru rispetto agli altri, con dati concreti e riferimenti quando possibile, per capire perché AIsuru potrebbe essere la scelta migliore.

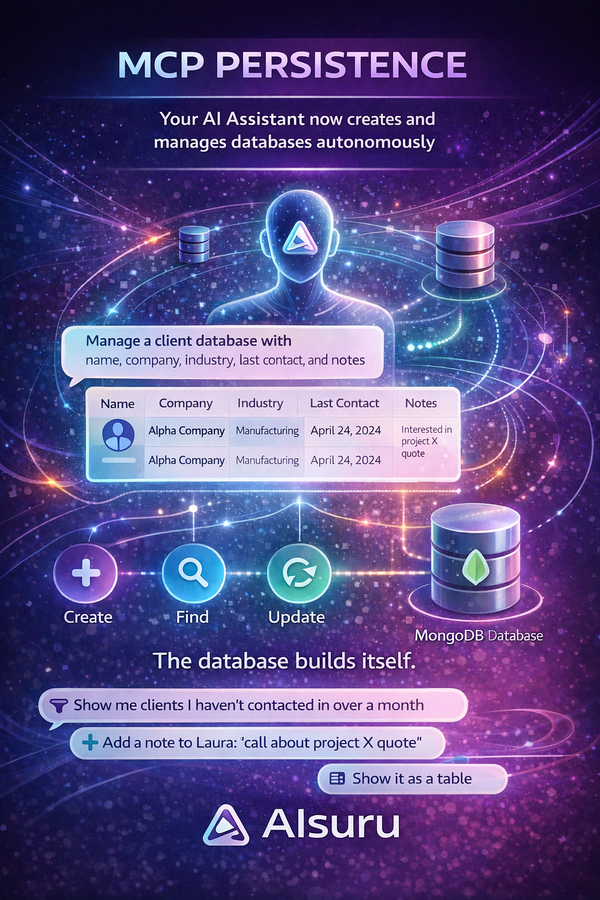

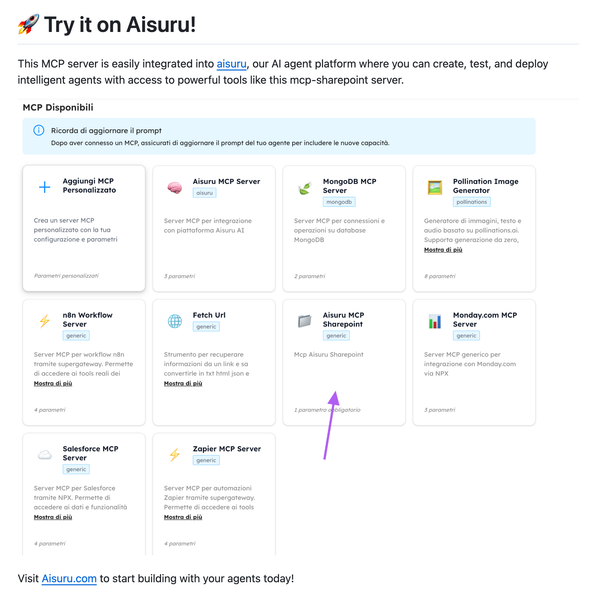

Capacità di personalizzazione

AIsuru – Offre un livello di personalizzazione molto elevato. Non è un singolo LLM, ma una piattaforma che può integrare diversi modelli linguistici esistenti (OpenAI GPT-3.5/GPT-4, Anthropic, Mistral, Google Gemini, modelli open source, ecc.) (Aisuru, che cos'è? | Memori AI) (Professionisti | Memori AI). L’utente può scegliere il modello generativo preferito o collegare le proprie API key (ad esempio di OpenAI, Mistral o Anthropic) per usare un provider specifico (Aisuru, che cos'è? | Memori AI). La piattaforma fornisce strumenti per plasmare la personalità e il comportamento del chatbot in modo semplice: ad esempio impostando istruzioni generali (anche con toni diversi: amichevole, formale, ecc.) (Professionisti | Memori AI). Il training è no-code e può avvenire conversando direttamente con l’agent e correggendolo: AIsuru consente infatti di modificare le risposte sbagliate o indesiderate durante i test, affinché l'Agente AI apprenda immediatamente le correzioni (Professionisti | Memori AI) (Professionisti | Memori AI). Inoltre supporta l’upload massivo di documenti, database, immagini, video e altri dati per arricchire la conoscenza del chatbot, con possibilità di integrazione via API a CMS esterni (Professionisti | Memori AI). Si possono anche definire intenti e funzioni custom (mini-applicazioni) per far eseguire azioni specifiche all’AI (What is Aisuru? | Memori AI). In sintesi, AIsuru permette di costruire un assistente AI completamente su misura, dai dati su cui è addestrato fino all’integrazione in sistemi esterni, il tutto con sforzo ridotto (approccio extreme no-code dichiarato) (Professionisti | Memori AI).

Lavoro PaaS di AIsuru per le aziende secondo Memori.ai

Dalla documentazione e dal sito Memori.ai, emerge chiaramente che AIsuru offre un'opzione Platform as a Service (PaaS) specificamente pensata per le aziende che desiderano una piattaforma AI brandizzata e completamente personalizzabile.

Cosa significa AIsuru come PaaS per le aziende?

- Piattaforma personalizzabile

- Le aziende possono accedere a un'istanza personalizzata di AIsuru con il proprio logo, branding e configurazioni specifiche.

- L’azienda può gestire direttamente utenti, chiavi API e impostazioni, garantendo un’esperienza AI su misura.

- Permette di controllare l’interfaccia e l’interazione con i propri clienti, evitando di usare un’AI generica con interfacce di terze parti.

- Gestione completa degli utenti e dei dati

- AIsuru PaaS consente gestione multiutente avanzata, con controlli sui permessi e differenziazione dell’esperienza utente in base ai ruoli aziendali.

- Amministrazione diretta delle chiavi API, evitando dipendenze da altri fornitori per la gestione dei modelli AI.

- Privacy e sicurezza GDPR compliant con la possibilità di scelta del deployment (cloud pubblico, private cloud o on-premise).

- Scalabilità e integrazione avanzata

- Si integra facilmente con CRM, sistemi aziendali, calendari, email e applicazioni proprietarie.

- Supporta l’embedding su siti web, totem fisici e ambienti VR, offrendo una presenza AI omnicanale.

- Possibilità di usare più modelli AI (GPT-4, Claude, Mistral, Bedrock, Azure, ecc.), selezionabili in base alle esigenze specifiche.

- Controllo totale sulle risposte e sui dati

- L’azienda può monitorare le conversazioni, correggere risposte errate e garantire coerenza nei contenuti forniti.

- Funzione di moderazione e revisione: le risposte possono essere controllate, migliorate e personalizzate per garantire la qualità dell'interazione AI.

- Protezione dei dati aziendali: i contenuti caricati restano privati e sicuri, senza essere utilizzati per il training di terzi.

- Soluzione ideale per aziende con requisiti di sicurezza elevati

- Per aziende con esigenze specifiche, AIsuru può essere ospitato in Private Cloud o On-Premise.

- Conformità all’AI Act Europeo, con assistenza legale per garantire l’uso etico e sicuro dell’IA.

- Supporto diretto e formazione dedicata attraverso l’AI Academy per integrare al meglio l’AI nelle operazioni aziendali.

Differenza tra PaaS e SaaS su AIsuru

- SaaS (Software as a Service) → Chiunque può registrarsi su AIsuru.com e usare la piattaforma pubblica con un sistema a crediti.

- PaaS (Platform as a Service) → Le aziende hanno un ambiente dedicato e personalizzato, con branding proprio, gestione autonoma degli utenti e dati, e opzioni di integrazione più avanzate.

Microsoft Copilot Studio – È la piattaforma low-code di Microsoft (nel contesto Power Platform) per creare “copilot” personalizzati. Consente di configurare agent conversazionali avanzati tramite un’interfaccia grafica drag-and-drop (Customize Copilot and Create Agents | Microsoft Copilot Studio). La personalizzazione avviene definendo topic di dialogo e incorporando 1200+ connettori di dati e applicazioni aziendali preconfigurati (Building your own copilot with Copilot Studio | Microsoft Copilot Blog) (Building your own copilot with Copilot Studio | Microsoft Copilot Blog). In pratica è possibile “collegare” il copilot a fonti come file aziendali, SharePoint, database interni, servizi SaaS (SAP, Salesforce, ecc.) e far sì che l’AI utilizzi i dati dell’organizzazione nelle risposte (Building your own copilot with Copilot Studio | Microsoft Copilot Blog). Si possono inoltre definire azioni che l’agente compie richiamando questi connettori (ad esempio recuperare un record CRM) e usare un gestore di dialoghi (dialog manager) per orchestrare flussi conversazionali complessi o guidare l’LLM in determinate sequenze (Building your own copilot with Copilot Studio | Microsoft Copilot Blog) (Building your own copilot with Copilot Studio | Microsoft Copilot Blog). Copilot Studio quindi offre un’ampia integrazione con l’ecosistema Microsoft, ma sul piano dei modelli generativi è legato ai LLM di Azure OpenAI (GPT-4, GPT-3.5) o equivalenti disponibili su Azure. Non supporta nativamente altri provider esterni oltre a quelli che Microsoft mette a disposizione. La configurazione richiede un minimo di competenze nell’usare gli strumenti Power Platform (è no-code, ma serve saper impostare connettori, prompt, ecc.), risultando comunque più tecnica rispetto all’approccio conversazionale di AIsuru.

Amazon Bedrock Agent Maker – Amazon Bedrock include la funzione “AI Agents” che permette di creare agenti conversazionali autonomi all’interno dell’infrastruttura AWS (Automate tasks in your application using AI agents - Amazon Bedrock). La personalizzazione avviene scegliendo un modello di base (Foundation Model) tra quelli supportati da Bedrock (es. Anthropic Claude, AI21 Jurassic, Amazon Titan, modelli di Meta/Mistral, ecc.) e fornendo istruzioni sull’obiettivo e comportamento dell’agente (Create and configure agent manually - Amazon Bedrock) (Create and configure agent manually - Amazon Bedrock). Si possono aggiungere “Action groups” per definire azioni che l’agente può compiere chiamando API o funzioni AWS (ad esempio eseguire una lambda per interagire con un sistema aziendale) (Automate tasks in your application using AI agents - Amazon Bedrock). Inoltre è possibile caricare o connettere una Knowledge Base con dati aziendali (con ricerca semantica) da cui l’agente può attingere per rispondere, usando query automatiche sui dati interni (Automate tasks in your application using AI agents - Amazon Bedrock). Bedrock permette persino di personalizzare i prompt di orchestrazione avanzati (pre-prompt, prompt di recupero conoscenza, post-prompt, ecc.) per adattare finemente il comportamento generativo (Automate tasks in your application using AI agents - Amazon Bedrock). In termini di integrazione, essendo su AWS, l’agente può interagire con tutti i servizi AWS e sistemi collegati all’account (tramite ruoli IAM e chiamate API). Tuttavia, rispetto ad AIsuru, questa piattaforma è orientata a sviluppatori: la configurazione avviene nel console AWS o via SDK, e sebbene non richieda di scrivere tutto il codice di orchestrazione (Amazon fornisce molto out-of-the-box), è meno user-friendly per un non tecnico. Non c’è un’interfaccia conversazionale “chiavi in mano” da fornire agli utenti finali senza sviluppo aggiuntivo (bisogna integrare l’agent in un’app o sito tramite API una volta creato) (Automate tasks in your application using AI agents - Amazon Bedrock) (Automate tasks in your application using AI agents - Amazon Bedrock). In sintesi, Bedrock Agent Maker è molto potente e flessibile sul piano tecnico, ma richiede competenze cloud/AWS; offre integrazione multi-modello (nell’ambito AWS) ma non supporta l’uso diretto di modelli OpenAI GPT (che non sono nativamente offerti da AWS Bedrock), al contrario di AIsuru che può orchestrare anche GPT di OpenAI.

OpenAI GPTs – In questo contesto si riferisce alla nuova possibilità offerta da OpenAI di creare versioni personalizzate di ChatGPT (“Custom GPTs”) direttamente dall’interfaccia ChatGPT (Introducing GPTs | OpenAI). La personalizzazione qui avviene fornendo istruzioni personalizzate, eventualmente aggiungendo conoscenza extra (upload di documenti o link a informazioni di riferimento) e selezionando eventualmente alcune abilità aggiuntive (Introducing GPTs | OpenAI). Ad esempio, si può creare un GPT personalizzato che abbia in memoria un certo manuale aziendale e istruirlo a rispondere solo sulla base di quello, oppure abilitarlo a usare strumenti come la ricerca web, la generazione di immagini con DALL-E o l’analisi dati con Code Interpreter (Introducing GPTs | OpenAI). Il tutto senza scrivere codice, tramite un semplice editor conversazionale. Questa flessibilità però ha dei limiti: il modello di base rimane quello di OpenAI (GPT-4 o GPT-3.5) e non è possibile sostituirlo o integrarne altri – a differenza di AIsuru che può instradare le richieste su modelli diversi. Le integrazioni con servizi esterni oltre a quelli previsti (i plugin OpenAI) richiedono sviluppo di un plugin custom, operazione non alla portata di un utente comune (People are missing the point with Custom GPTs. Let me explain ...). Inoltre, i GPT personalizzati di OpenAI vivono principalmente dentro l’ecosistema ChatGPT: possono essere condivisi con altri utenti via link o pubblicati (in futuro) nel marketplace OpenAI, ma non c’è un metodo nativo per incorporarli in un proprio sito/applicazione esterna come chatbot white-label. In pratica, per un’azienda che volesse un chatbot sul proprio sito con un suo dominio, l’opzione OpenAI equivarrebbe a usare l’API OpenAI tradizionale e costruire da sé tutta l’applicazione conversazionale (UI, logica, integrazioni) – approccio che richiede tempo di sviluppo e manutenzione, come sottolinea anche Memori riguardo all’alternativa di usare direttamente le API dei modelli linguistici (Professionals | Memori AI). AIsuru invece fornisce già tutta l’infrastruttura pronta all’uso.

Sintesi: Tutte le soluzioni offrono un certo grado di personalizzazione, ma AIsuru spicca per la sua flessibilità: supporto multi-modello (nessun lock-in su un singolo provider), addestramento conversazionale no-code continuo, importazione diretta di dati e documenti, possibilità di integrazione sia con servizi cloud sia on-premise. Copilot Studio e Bedrock Agents sono potenti ma legati ai rispettivi ecosistemi (Microsoft e AWS) e richiedono competenze specifiche; i GPT di OpenAI sono facili da creare ma limitati all’ambiente ChatGPT stesso. AIsuru unisce la potenza dei modelli generativi più avanzati con un ambiente di configurazione user-friendly e aperto.

Qualità delle risposte

AIsuru – La qualità delle risposte dipende in primo luogo dal modello LLM sottostante scelto per il proprio agente. Grazie al supporto per modelli leader come GPT-4 di OpenAI o Claude di Anthropic, AIsuru può fornire risposte di qualità allo stato dell’arte in termini di comprensione e coerenza (Professionisti | Memori AI). Un vantaggio chiave di AIsuru è che consente di combinare l’intelligenza generativa con conoscenza controllata: caricando documenti aziendali o basi di conoscenza e usando il suo NLP multi-strato, il chatbot può fornire risposte accuratamente aderenti ai contenuti forniti dall’utente (es. policy aziendali, manuali interni) invece di inventare risposte. Inoltre, l’amministratore dell’AI rimane “sempre in controllo delle risposte”: tramite la console AIsuru si possono verificare le conversazioni e correggere eventuali output scorretti, affinché l’AI non ripeta errori in futuro (Professionisti | Memori AI) (Professionisti | Memori AI). Questo meccanismo di reinforcement learning manuale significa che la qualità può migliorare nel tempo: il chatbot impara ad essere più preciso man mano che viene affinato con feedback umani. AIsuru impiega anche tecniche NLP proprietarie (ad esempio l’uso di FastText per classificazione rapida) per gestire risposte rapide a domande frequenti o semplici, garantendo coerenza e velocità (Aisuru, che cos'è? | Memori AI). In termini di creatività, usando modelli come GPT-4, AIsuru può generare contenuti molto articolati e creativi. Tuttavia, grazie ai “dizionari custom” e alle impostazioni di tono, si può anche controllare lo stile creativo rendendolo più o meno fantasioso a seconda dell’esigenza (Professionisti | Memori AI). In conversazioni lunghe o complesse, AIsuru può sfruttare modelli con contesti estesi (es. GPT-4 32k token, Claude 100k) se disponibili, e la sua infrastruttura su AWS garantisce la gestione della memoria conversazionale in modo stabile. In sintesi, AIsuru può raggiungere un’elevata accuratezza e consistenza (grazie all’integrazione di conoscenza specifica e correzione continua) senza sacrificare la creatività tipica dei migliori LLM generativi.

Microsoft Copilot Studio – La qualità delle risposte nei copiloti costruiti con questa piattaforma è anch’essa molto alta, poiché Microsoft vi integra modelli generativi di prima fascia (Azure OpenAI GPT-4, probabilmente affiancato in futuro da PaLM 2 di Google via Azure Cognitive Services, ecc.). Nelle demo e documentazioni Microsoft si evidenzia che con l’uso di generative AI i bot risultano subito utili anche senza dialoghi pre-scritti (Microsoft Copilot Studio: Conversational AI for Everyone). Copilot Studio inoltre permette di ancorare le risposte ai dati reali aziendali: l’agente può essere “grounded” su file, database e altre fonti (anche in tempo reale) (Building your own copilot with Copilot Studio | Microsoft Copilot Blog). Ciò significa che la correttezza fattuale delle risposte può essere elevata – ad esempio il copilot può rispondere citando i dati di vendita aggiornati o le policy esatte prese dal SharePoint, riducendo le allucinazioni. Per gestire conversazioni complesse, Copilot Studio offre il Dialog Manager con cui si possono impostare risposte guidate o flussi deterministici per determinati temi, assicurando coerenza dove necessario (Building your own copilot with Copilot Studio | Microsoft Copilot Blog). La creatività delle risposte è modulabile: si possono lasciare interazioni aperte al modello generativo (che darà risposte simili a ChatGPT, quindi molto naturali e articolate), oppure prevedere prompt specifici e regole per argomenti sensibili. Essendo pensato per contesti enterprise, c’è un’attenzione a mantenere un tono professionale e controllato nelle risposte – ad esempio i modelli Azure OpenAI possono avere filtri di contenuto e moderazione integrati. In generale, la qualità dei copiloti di Microsoft sarà comparabile a quella di ChatGPT (dato che il modello è lo stesso), con in più la capacità di eseguire azioni e di consultare informazioni aziendali: ciò li rende molto efficaci nel risolvere richieste pratiche (ad es. “Qual è lo stato dell’ordine X?” con risposta accurata via connettore SAP). Un possibile limite è che, al di fuori dei dati forniti nei connettori, il copilot non ha una conoscenza generale ampia come ChatGPT pubblico, a meno che non gli si dia accesso a Bing per ricerche web (ma nelle soluzioni aziendali questo potrebbe non essere abilitato per motivi di privacy). AIsuru in confronto permette sia conoscenza generale (del modello scelto) sia conoscenza specifica caricata, un mix simile viene perseguito anche da Copilot Studio ma all’interno dell’ambiente Microsoft.

Amazon Bedrock Agents – La qualità delle risposte fornite dagli agenti Bedrock dipende dal foundation model selezionato. AWS offre modelli come Anthropic Claude 2, noto per eccellere in capacità di reasoning e contesto esteso, e modelli di AI21 Labs (Jurassic 2) noti per buone capacità linguistiche, oltre ai modelli proprietari Amazon (come Titan) e altri open source. Anche se GPT-4 non è incluso, modelli come Claude v2 sono comparabili per molti versi a GPT-3.5/GPT-4 in qualità linguistica. Inoltre, Bedrock Agents arricchiscono le risposte tramite conoscenza aziendale e azioni, il che aumenta accuratezza e utilità: l’agente può spezzare un compito complesso in passi, chiedere chiarimenti all’utente se necessario, eseguire calcoli o operazioni chiamando API e poi sintetizzare il risultato per l’utente (Automate tasks in your application using AI agents - Amazon Bedrock). Questa orchestrazione fa sì che le risposte siano coerenti con le richieste dell’utente e supportate dai dati: ad esempio, a una domanda su una polizza assicurativa, l’agente potrebbe recuperare i dettagli dal database (via knowledge base) e restituire una risposta precisa citando quei dettagli. La piattaforma gestisce la memoria conversazionale e il prompt engineering automaticamente (Automate tasks in your application using AI agents - Amazon Bedrock), il che tende a mantenere il contesto e la coerenza su più turni. In termini di creatività, i modelli disponibili (es. Claude) sono capaci di generare testi elaborati e creative storytelling, sebbene AWS Bedrock sia focalizzato più su task completion che sulla creatività fine a sé stessa. Un agente Bedrock configurato per un compito aziendale privilegerà risposte accurate e azioni corrette rispetto a divagazioni creative. AIsuru e Bedrock in realtà condividono una filosofia simile sull’importanza di arricchire l’LLM con azioni e conoscenza (la distinzione tra un semplice chatbot e un “agente IA davvero efficace” è proprio la capacità di eseguire azioni concrete oltre alla generazione di testo (Blog | Memori AI)). In conclusione, la qualità delle risposte in Bedrock Agent Maker è molto alta su compiti specifici (grazie all’orchestrazione di API e dati), leggermente limitata in generale dalla scelta di modelli (non potendo usare GPT-4 direttamente). AIsuru, permettendo anche l’uso di GPT-4, potrebbe dare risposte più fluenti o creative in certi ambiti, ma Bedrock eccellerà in precisione operativa in un contesto AWS integrato.

OpenAI GPTs (Custom ChatGPT) – Qui la qualità del modello è il punto forte: usando GPT-4 di OpenAI, le risposte generative sono attualmente considerate lo stato dell’arte in molte metriche di accuratezza, comprensione del linguaggio e creatività. GPT-4, ad esempio, ha superato test umani in vari domini ed è noto per la sua coerenza nel seguire istruzioni complesse e produrre risposte dettagliate e contestuali. Un GPT personalizzato creato dall’utente beneficia di questa potenza: partendo da un modello pre-addestrato su una vastissima base di conoscenze, può affrontare conversazioni complesse mantenendo il filo logico e generando output di qualità elevata. Inoltre, l’utente può aggiungere file di conoscenza specifici (PDF, testi) che il GPT utilizzerà come riferimento: ciò migliora l’accuratezza nelle risposte su argomenti di nicchia (per esempio, se carico un manuale tecnico e imposto che risponda usando solo quel riferimento, le risposte saranno molto pertinenti a quel testo). Va detto che questa meccanica è efficace entro i limiti di contesto del modello – se i documenti sono molti o molto lunghi, potrebbero non entrare tutti nel prompt ai fini della risposta. La creatività dei GPT di OpenAI è ben nota (dalla scrittura di storie, poesie, alla risoluzione di problemi in modi originali); l’utente può sfruttarla nelle istruzioni, ad esempio creando un assistente “più creativo” o “più rigoroso” a seconda del tono scelto nelle custom instructions. OpenAI GPT gestisce ottimamente anche i dialoghi multi-turn complessi, con capacità di fare domande di chiarimento all’utente se qualcosa non è chiaro. Un aspetto di qualità è la robustezza linguistica: supporta molte lingue (compreso l’italiano) in modo naturale e può passare da una lingua all’altra, il che è utile per creare chatbot multilingue. Sia AIsuru che Copilot Studio supportano anch’essi il multilingua (AIsuru dichiara esplicitamente che un Agente può parlare “tutte le lingue del mondo” (Professionals | Memori AI), appoggiandosi ai modelli sottostanti). In sintesi, la qualità intrinseca delle risposte di un GPT OpenAI è eccellente; tuttavia, la capacità di OpenAI GPT di aderire esattamente a informazioni aziendali potrebbe essere un po’ inferiore rispetto ad AIsuru o Copilot, in quanto OpenAI GPTs dipende principalmente dal prompt e dai file caricati per “ricordare” info specifiche, ma non ha un sistema integrato di aggiornamento continuo/correzione da parte dell’admin come AIsuru né l’orchestrazione strutturata di Copilot/Bedrock. Dunque, rischia più facilmente di dare qualche risposta allucinata se le istruzioni o i dati forniti non coprono un caso – a meno di intervenire con prompt molto ben congegnati.

Sintesi: In termini di qualità, tutte le soluzioni possono raggiungere livelli alti, soprattutto sfruttando i migliori LLM disponibili. AIsuru ha il vantaggio di unire i migliori modelli (incluso GPT-4) con la curation umana continua, assicurando risposte accurate al contesto aziendale. Copilot Studio e Bedrock puntano su LLM + dati aziendali + azioni per risposte utili e precise in ambito enterprise. OpenAI GPT offre la massima creatività e fluidità grazie a GPT-4, ma potrebbe richiedere più attenzione per limitarne le allucinazioni in contesti specialistici. Nel complesso AIsuru, potendo scegliere e combinare strategie (modello generativo potente, conoscenza caricata, intervento umano sulle risposte), ha i mezzi per garantire risposte sia pertinenti che affidabili nel tempo.

Costo

AIsuru – Adotta un modello a abbonamento con crediti mensili. Sono disponibili diversi piani (indicati sul sito come Seed, Boost, Brain, Supernova), che mettono a disposizione rispettivamente 400, 1000, 2800, 6000 crediti (AIsuru - Subscriptions Plans) (AIsuru - Subscriptions Plans). I crediti rappresentano le richieste al servizio AI (ad esempio, presumibilmente 1 credito ≈ 1 messaggio o una certa quantità di token elaborati – il dettaglio esatto non è pubblico, ma l’uso di crediti suggerisce un tetto mensile di interazioni). I piani più alti includono funzionalità aggiuntive, come la gestione multiutente (disponibile per abbonamenti di livello avanzato) (Professionisti | Memori AI). Non sono stati resi pubblici i prezzi in euro/dollari per ciascun piano sul sito ufficiale; molto probabilmente AIsuru propone soluzioni scalabili e personalizzate, con la possibilità di contattare Memori per piani Enterprise su misura (AIsuru - Subscriptions Plans). Questo approccio a crediti offre il vantaggio di prevedibilità dei costi: l’azienda sa quante interazioni ha incluse al mese. AIsuru enfatizza anche come utilizzare la loro piattaforma possa far risparmiare tempo e costi di sviluppo rispetto a costruire da zero un’integrazione con le API di un LLM (Professionals | Memori AI). Inoltre, AIsuru permette di ospitare modelli open-source on-premise: se un cliente sceglie di usare un proprio modello locale (es. Llama2) per alcune conversazioni, potrebbe abbattere i costi variabili (pagando solo l’infrastruttura hardware) rispetto all’uso di API a consumo (Aisuru, che cos'è? | Memori AI). In sintesi, i costi di AIsuru sono strutturati per abbonamento (adatti alle aziende che vogliono un costo fisso mensile) e possono risultare competitivi considerando che includono anche il servizio completo (interfacce, dashboard, aggiornamenti, supporto) oltre alle chiamate AI.

Microsoft Copilot Studio – Questo servizio fa parte dell’offerta Microsoft 365 (Power Platform). Attualmente Microsoft lo propone con due modelli di prezzo: uno fisso mensile e uno a consumo (pay-as-you-go). Ad esempio, nel listino è indicato $200/mese per 25.000 messaggi inclusi (Customize Copilot and Create Agents | Microsoft Copilot Studio), con possibilità di prova gratuita. In alternativa, chi ha un’infrastruttura Azure può scegliere la modalità consumo senza impegno, pagando solo per i messaggi effettivamente utilizzati (Customize Copilot and Create Agents | Microsoft Copilot Studio) (richiede comunque una sottoscrizione Azure attiva (Customize Copilot and Create Agents | Microsoft Copilot Studio)). A questi costi vanno aggiunti eventuali costi dei servizi sottostanti: Copilot Studio utilizza Azure OpenAI Service per i modelli GPT, quindi il prezzo dei token generati potrebbe essere incorporato nel costo per messaggio, oppure calcolato a parte in caso di uso pay-as-you-go (in generale Microsoft tende a semplificare addebitando un unico costo per messaggio, come indicato). Per le aziende già abbonate a Microsoft 365 Copilot (la suite di AI integrata in Office), Copilot Studio potrebbe essere incluso o disponibile con un sovrapprezzo: ad esempio M365 Copilot per utente costa $30 al mese (Customize Copilot and Create Agents | Microsoft Copilot Studio), ma è un prodotto distinto focalizzato su Office. Quindi $200/mese per 25k messaggi è il riferimento per un agente aziendale personalizzato. Questo costo è significativamente più alto di, ad esempio, un abbonamento ChatGPT Plus ($20/mese) ma bisogna considerare che è rivolto a organizzazioni e consente interazioni con n utenti (25k messaggi possono essere conversazioni con molti clienti). Rispetto ad AIsuru, è probabile che la fascia di prezzo sia simile al piano “Brain” o “Supernova” di AIsuru in termini di spesa mensile, ma con Copilot Studio si è vincolati a Microsoft (e.g. se servono più di 25k messaggi si deve acquistare add-on o passare a consumo). L’integrazione con dati aziendali via connettori è compresa nel prezzo di Copilot Studio (ma attenzione che l’uso intensivo di alcuni connettori o Azure services potrebbe generare costi Azure separati, ad esempio scrivere/leggere molto da un database potrebbe avere costi Azure). In definitiva, Copilot Studio richiede un investimento significativo, giustificato dal valore enterprise: AIsuru potrebbe risultare più conveniente per implementazioni su misura moderate, mentre Copilot conviene se già si investe nell’ecosistema Microsoft e si punta a un ampio utilizzo interno.

Amazon Bedrock Agent Maker – Amazon Bedrock adotta un modello pay-per-use per inferenze e funzioni, con possibilità di sconti su impegni di throughput. Non c’è un canone mensile base: si paga in base ai token elaborati dai modelli generativi (input e output) e alle risorse impiegate. I costi variano a seconda del modello scelto. Ad esempio, usando un modello AI21 “J2-Jumbo” (chiamato “Command”): il costo è circa $0,0015 per 1.000 token di input e $0,0020 per 1.000 token di output (Amazon Bedrock Pricing: The Complete Guide). Modelli più piccoli (“Command-Light”) costano meno (circa $0,0003 per 1k token input) (Amazon Bedrock Pricing: The Complete Guide). Modelli più complessi come Anthropic Claude 2 avranno costi più elevati (indicativamente, Claude 2 su Bedrock è stato annunciato con prezzo ~$0,011 per 1k token input e ~$0,032 per 1k output, allineato al prezzo di Anthropic API, sebbene i precisi valori AWS possano variare). Amazon offre due piani: On-Demand (a consumo puro) e Provisioned Throughput (dove l’azienda si impegna per una capacità oraria fissa per 1 o 6 mesi, ottenendo tariffe più basse) (Build Generative AI Applications with Foundation Models – Amazon Bedrock Pricing – AWS) (Build Generative AI Applications with Foundation Models – Amazon Bedrock Pricing – AWS). Inoltre, la modality Batch (invio di molti prompt in blocco) costa ~50% in meno rispetto al real-time (Automate tasks in your application using AI agents - Amazon Bedrock) (Automate tasks in your application using AI agents - Amazon Bedrock), utile per processare grandi moli di dati offline. Oltre ai costi di modello, potrebbero esserci costi per la knowledge base (ad es. se si utilizza Amazon Kendra per indicizzare documenti) e per le API chiamate (le action eseguite potrebbero coinvolgere Lambda, DynamoDB, ecc., che hanno i loro costi). In sintesi, il costo di Bedrock Agent Maker è variabile e direttamente proporzionale all’uso. Questo è ottimo per sperimentare con basso utilizzo (si paga magari pochi centesimi per qualche decina di messaggi), ma può diventare molto costoso con alti volumi (es: 1 milione di token input e output con un modello avanzato potrebbe costare decine di dollari). AIsuru, offrendo pacchetti fissi di crediti, potrebbe risultare più economico e prevedibile per un usage medio, mentre su Bedrock il vantaggio è pagare esattamente l’uso (e spegnere quando non serve). Da notare che AWS tende ad avere sconti per grandi clienti e si integra con eventuali piani già esistenti dell’azienda su AWS. Per un confronto, Amazon ha stimato un esempio di costo mensile di ~$28.500 per un’istanza di modello grande sempre attiva h24 (A Comprehensive Guide to AWS Bedrock Pricing | CloudForecast), il che dà l’idea che l’uso intensivo di modelli generativi su larga scala è oneroso ovunque. AIsuru potrebbe quindi essere più conveniente per PMI o casi d’uso medi, mentre Bedrock può convenire a chi ha già infrastrutture AWS e vuole scalare dinamicamente pagando solo l’uso.

OpenAI GPTs – Creare e usare un GPT custom tramite ChatGPT richiede almeno un abbonamento ChatGPT Plus ($20/mese per utente) (Introducing ChatGPT Plus | OpenAI). ChatGPT Plus dà accesso a GPT-4 (fino ~50 messaggi ogni 3 ore, sufficienti per uso personale/prototipi) e consente di creare GPT personalizzati senza costi aggiuntivi, finché l’uso rientra nell’uso personale “ragionevole” (ChatGPT Pricing | OpenAI) (ChatGPT Pricing | OpenAI). Per un singolo sviluppatore o professionista, $20/mese è un costo basso e accessibile. Tuttavia, se parliamo di utilizzo aziendale esteso, occorre considerare ChatGPT Enterprise o l’API OpenAI. ChatGPT Enterprise è offerto con prezzo personalizzato in base al numero di utenti (non divulgato pubblicamente, ma alcune fonti indicano che potrebbe aggirarsi su decine di dollari per utente al mese, includendo uso illimitato di GPT-4). In alternativa, l’API di OpenAI ha costo a consumo per token: ad esempio GPT-4 8k context costa $0,03 per 1K token in input e $0,06 per 1K token in output, GPT-3.5 Turbo costa $0,0015 per 1K token in input e $0,0020 per 1K in output. Ciò significa che ~1000 messaggi medi con GPT-4 possono costare qualche decina di dollari in token. Dal punto di vista dei costi, dunque, OpenAI GPT (via API) e AWS Bedrock sono modelli simili – paghi l’uso effettivo. L’infrastruttura (interfaccia chatbot, database conversazioni, ecc.) però nel caso OpenAI deve essere sviluppata a parte, il che aggiunge costi di sviluppo/manutenzione. Invece con ChatGPT Plus, l’interfaccia è fornita ma non è brandizzabile né integrabile sul proprio sito. Bisogna inoltre menzionare che creare un GPT custom di OpenAI è gratuito per ora (incluso in Plus), e condividerlo con altri non genera di per sé un costo per l’autore, ma se molti utenti utilizzassero quel GPT, presumibilmente OpenAI potrebbe porre limiti o proporre un modello di remunerazione in futuro (la situazione è in evoluzione con l’arrivo del GPT Store). Dunque, per uso aziendale interno limitato (pochi utenti), OpenAI Plus è la via più economica. Per un chatbot pubblico rivolto a clienti, invece, servirebbe usare l’API a consumo o far aderire ogni utente al proprio Plus, cosa impraticabile: in questo caso i costi a consumo OpenAI possono crescere rapidamente. AIsuru ha dalla sua parte il fatto che nel prezzo offre anche la piattaforma completa e la possibilità di utilizzare modelli open source a costo marginale; un’azienda che opta per “farsi il chatbot in casa” con l’API di OpenAI potrebbe trovarsi a spendere di meno in pura computazione se il traffico è basso, ma deve investire in sviluppo e assumersi i costi di mantenimento (che spesso superano il risparmio sui token). Infine, sul fronte licenze, AIsuru ed altri offrono contratti con DPA e garanzie di utilizzo commerciale, mentre l’uso di ChatGPT free/Plus per dati aziendali potrebbe violare termini o non garantire privacy (discusso in sezioni successive). In termini di ROI, AIsuru rende i costi di implementazione di un assistente AI più certi e inclusivi, mentre OpenAI fornisce il building block (modello) a basso costo ma lascia all’utente tutto il resto.

Sintesi: Il modello di costo varia notevolmente. AIsuru adotta un approccio SaaS a pacchetto, ideale per pianificare la spesa e avere tutto compreso (hosting, aggiornamenti, supporto). Copilot Studio ha un costo elevato pensato per enterprise Microsoft (licenza mensile significativa o consumo Azure), giustificato dall’integrazione profonda ma probabilmente sovradimensionato per piccole realtà. AWS Bedrock è pay-per-use, molto flessibile – si paga solo ciò che si usa – ma richiede attenzione per non sforare il budget con alti volumi. OpenAI GPT è economicamente vantaggioso per uso individuale (Plus a $20) e competitivo a consumo per singole funzioni, ma per un progetto custom completo bisogna sommare i costi di sviluppo. Il punto di forza di AIsuru è offrire un prezzo prevedibile per una soluzione chiavi in mano, potenzialmente più economica rispetto a dover assemblare e mantenere tutti i componenti separatamente.

La soluzione PaaS di Aisuru poi porta la personalizzazione e la gestione private a un nuovo livello.

Perché AIsuru PaaS è un vantaggio per le aziende

- Brandizzazione completa della piattaforma, con un ambiente AI costruito su misura.

- Sicurezza e privacy di alto livello con opzioni di cloud privato o on-premise.

- Controllo totale sui dati e sulle risposte AI, evitando "allucinazioni" e risposte errate.

- Scalabilità e multicanalità, permettendo di usare AI su diversi touchpoint aziendali.

- Facilità di gestione e utilizzo, senza necessità di sviluppo tecnico avanzato.

AIsuru PaaS è quindi un’ottima soluzione per aziende che vogliono implementare AI conversazionale senza dipendere da provider esterni e mantenendo pieno controllo su branding, sicurezza e integrazione con i propri sistemi aziendali.

Facilità d’uso

AIsuru – Pensato per essere usabile anche da non programmatori: l’esperienza utente è completamente no-code e focalizzata sulla semplicità. La creazione di un Agente AI in AIsuru è descritta come immediata, “in un attimo” (Professionisti | Memori AI) – l’AI comincia subito a rispondere e ad imparare. L’interfaccia di AIsuru consente di impostare parametri con semplici moduli testuali (es. descrivere in linguaggio naturale la personalità desiderata) e poi di addestrare conversando: basta dialogare con il proprio agente e affinarne le risposte direttamente, senza scrivere codice (Professionisti | Memori AI). Questo approccio conversazionale riduce drasticamente la curva di apprendimento: chiunque sappia utilizzare una chat e abbia chiari i contenuti da trasferire può creare un assistente. Sono presenti funzionalità per caricare dati (upload file) con pochi click e integrazioni tramite API relativamente semplici da configurare quando servono (per chi ha competenze tecniche, è possibile estendere, ma non è obbligatorio per iniziare). AIsuru fornisce widget pronti da incorporare in siti web, totem, applicazioni, ecc. tramite copia-incolla di snippet o chiamate API (Professionisti | Memori AI), facilitando la distribuzione omnicanale. Anche la gestione dell’assistente (monitoraggio conversazioni, statistiche d’uso (Professionisti | Memori AI)) avviene in una dashboard web intuitiva. Inoltre, Memori offre l’AI Academy con corsi per formare professionisti sull’uso di AIsuru (What is Aisuru? | Memori AI) (What is Aisuru? | Memori AI), segno che l’azienda investe per rendere l’onboarding il più semplice possibile. In sintesi, AIsuru eccelle per facilità d’uso: “non serve codice, basta parlargli” come dicono sul sito (Professionisti | Memori AI), e questo claim risulta confermato dall’architettura no-code estremamente guidata.

Microsoft Copilot Studio – È una soluzione low-code, il che implica un maggior grado di complessità rispetto a AIsuru. Si rivolge a “makers” nell’ambito Power Platform: utenti business con un minimo di competenza in strumenti come Power Apps, Power Automate, ecc. L’ambiente di sviluppo è integrato nella Power Platform Admin Center (Customize Copilot and Create Agents | Microsoft Copilot Studio) e offre un canvas grafico dove trascinare componenti, impostare connessioni ai dati (bisogna configurare i connettori alle fonti volute) e definire l’aspetto del dialogo. La presenza di tanti connettori e opzioni è un’arma a doppio taglio: da un lato consente quasi ogni integrazione immaginabile, dall’altro può risultare complesso scegliere e impostare tutto correttamente. Microsoft cerca di semplificare con funzionalità di NLU generativo anche nella creazione (ad esempio, in Copilot Studio si può descrivere in linguaggio naturale un caso d’uso e la piattaforma aiuta a creare i topic automaticamente) (AI-based agent authoring overview - Microsoft Copilot Studio). Ciò riduce il lavoro manuale di configurazione. Inoltre, essendo integrato nell’ecosistema M365, chi è già pratico di Teams, SharePoint, etc., troverà familiare il concetto di pubblicare il copilot su questi canali (c’è una buona continuità di esperienza). Per distribuire un copilot su un sito web esterno, probabilmente va utilizzato Power Pages o embed con un iframe; non è plug&play come AIsuru, ma comunque documentato. Microsoft fornisce guide passo-passo e quickstart (Master Autonomous AI Agents in Microsoft Copilot Studio - YouTube) (Quickstart: Create and deploy an agent - Microsoft Copilot Studio), e la community Power Platform è attiva nel condividere tutorial (YouTube presenta già video su “Build your first agent with Copilot Studio”). Tuttavia, per un utente completamente non tecnico, Copilot Studio può risultare intimidatorio inizialmente, dovendo maneggiare concetti come intents, entities, integrazione API attraverso connettori, ecc. In confronto, AIsuru nasconde gran parte di questa complessità dietro un’interfaccia conversazionale. D’altro canto, sviluppatori citizen che hanno già creato chatbot con Power Virtual Agents troveranno Copilot Studio un enorme passo avanti in semplicità rispetto al passato (dove bisognava scrivere molti flussi manuali – ora il generative AI riempie le lacune). Riassumendo: Copilot Studio è abbastanza facile per utenti business “pro”, ma meno immediato di AIsuru per chi parte da zero.

Amazon Bedrock Agent Maker – L’uso di Bedrock Agents è decisamente orientato a sviluppatori/cloud architect. La console AWS per Bedrock Agents consente di creare e configurare l’agente via interfaccia, ma presuppone conoscenze come la gestione di ruoli IAM, comprensione di API e formati di prompt, ecc. (Create and configure agent manually - Amazon Bedrock) (Create and configure agent manually - Amazon Bedrock). La curva di apprendimento include familiarizzarsi con concetti come Action groups, knowledge base embeddings, ecc., spiegati nella documentazione AWS (molto dettagliata ma tecnica). Non c’è una semplice procedura guidata in linguaggio naturale per “descrivere l’agente” come altrove; piuttosto si compilano campi di configurazione (nome agente, istruzioni, scelta modello…) e poi si aggiungono componenti. La necessità di eventualmente impostare una vector database per la knowledge base o scrivere una funzione Lambda per un’Action richiede abilità di programmazione. In pratica, Bedrock Agents è facile per chi già sviluppa su AWS (niente infrastruttura server da predisporre, AWS pensa a tutto il back-end), ma non è pensato per un utente business senza competenze tecniche. L’assenza di un’interfaccia end-user integrata significa che per far utilizzare l’agente a utenti finali bisogna scrivere almeno una semplice applicazione (ad esempio, uno script Python che chiama l’API dell’agente e presenta la risposta). AWS fornisce SDK in vari linguaggi per facilitare l’integrazione (build-on-aws/amazon-bedrock-agents-quickstart - GitHub) (Building Custom Amazon Bedrock Agents for Automation from Scratch), ma di nuovo siamo in territorio da sviluppatore. In termini di supporto all’usabilità, Amazon offre tutorial, e partner AWS possono costruire soluzioni su misura, ma non c’è nulla di simile all’Academy di AIsuru per formare “creator” non programmatori. Pertanto, AIsuru è molto più facile da usare per un’azienda che non dispone di sviluppatori dedicati, mentre Bedrock è uno strumento potente nelle mani di un team tecnico.

OpenAI GPTs – La creazione di un custom GPT tramite ChatGPT è molto semplice a livello di interfaccia: come utente Plus si va nella sezione “My GPTs” e si seguono pochi passi (dare un nome, un’immagine, scrivere le istruzioni e aggiungere eventuali dati caricati) (Creating a GPT | OpenAI Help Center). Questo processo è disegnato per essere fattibile da chiunque sappia usare ChatGPT: nessuna competenza tecnica richiesta. In pochi minuti si può ottenere un bot personalizzato funzionante. Dunque, per prototipazione e uso personale è probabilmente lo strumento più immediato in assoluto. La difficoltà però arriva se l’obiettivo è usare quel GPT in un contesto diverso dalla chat di OpenAI: come detto, non esiste un canale integrato di deploy su altri piattaforme (non posso “mettere” facilmente il mio GPT su WhatsApp, su webchat, etc., senza ricorrere alle API di sviluppo). Inoltre, la gestione utenti non è flessibile: se voglio far usare il mio GPT custom a 100 clienti, devo generare 100 link di accesso (o i clienti devono avere un account OpenAI per interagire). Questo aspetto organizzativo/logistico rende la soluzione OpenAI GPTs poco usabile per distribuzione di massa fuori dall’ambiente ChatGPT. Invece AIsuru e Copilot generano chatbot fruibili tramite URL pubblici o integrazioni site/app senza che l’utente finale debba fare login in una terza parte. Sul fronte sviluppo tradizionale con OpenAI API: qui l’usabilità dipende dalla bravura del team nello sviluppare l’applicazione – in pratica è programmazione classica, quindi molto flessibile ma tutt’altro che pronta all’uso. In breve, OpenAI GPTs vince in facilità di creazione (basta un prompt), AIsuru vince in facilità di implementazione (fornisce direttamente il prodotto finito utilizzabile). Va notato che OpenAI fornisce abbondante documentazione e la community di utilizzatori è enorme (tutorial, prompt guide, ecc.), quindi reperire informazioni è semplice, ma questo non elimina lo sforzo di far da sé l’applicazione se si sceglie la via API.

Sintesi: AIsuru è chiaramente progettato per la massima semplicità d’uso lato creatore e lato utente finale, con un vero approccio no-code: in pochi click e qualche riga di testo descrittivo si può avere un Agente AI funzionante e integrabile ovunque (Professionisti | Memori AI) (Professionisti | Memori AI). Copilot Studio semplifica molto rispetto allo sviluppo custom, ma rimane un ambiente low-code professionale, ideale per aziende già nel mondo Microsoft ma meno immediato di AIsuru. Bedrock richiede competenze tecniche, quindi non è “user friendly” per tutti, mentre OpenAI GPTs è facilissimo da creare ma difficile da distribuire su larga scala al di fuori dell’interfaccia ChatGPT. In conclusione, se l’obiettivo è dare in mano anche a personale non ICT la possibilità di creare e gestire un’assistente AI, AIsuru offre l’esperienza più accessibile.

Velocità e prestazioni

AIsuru – Grazie alla sua architettura ibrida, AIsuru offre tempi di risposta rapidi. Utilizza un sistema NLP multilivello che include FastText per compiti di riconoscimento immediati, consentendo ad esempio di classificare intent o recuperare alcune risposte semplici in appena 20 microsecondi (Aisuru, che cos'è? | Memori AI). Quando invece è coinvolto un LLM generativo (es. GPT-4), i tempi dipendono dal modello esterno: AIsuru sfrutta infrastruttura AWS che garantisce scalabilità e affidabilità (istanze adeguate, bilanciamento carico) (Aisuru, che cos'è? | Memori AI). In pratica, una query inviata ad AIsuru che usa un modello OpenAI avrà latenze simili a una chiamata diretta a OpenAI più un leggero overhead di orchestrazione. Questo overhead AIsuru lo minimizza con ottimizzazioni (ad esempio parallelizzando eventuali richieste a knowledge base interna, o usando risposte pre-compilate per domande frequenti). Memori dichiara che l'Agente inizia a rispondere “subito” e impara nel tempo (Professionisti | Memori AI), indicando che il sistema è reattivo già out-of-the-box. Inoltre, per clienti enterprise con requisiti stringenti, AIsuru può essere installato on-premise su hardware dedicato (Lenovo) con GPU ottimizzate (What is Aisuru? | Memori AI), eliminando la latenza di rete verso servizi esterni e garantendo prestazioni costanti anche offline. Questo è un punto di forza: in ambienti isolati (es. militari, fabbriche senza internet) l'Agente può funzionare a velocità massima locale. Anche nelle versioni cloud, AIsuru beneficia della presenza di AWS datacenter globali – e presumibilmente può ospitare agenti in region di prossimità all’utente per ridurre latenza. Infine, il sistema di cache e prompt management di AIsuru (citato tra le feature c’è “ottimizzare il comportamento delle AI”, che spesso include caching di risposte) potrebbe permettere risposte quasi istantanee a domande già poste in precedenza. In sintesi, AIsuru offre ottime prestazioni: near real-time per interazioni brevi e un efficace bilanciamento tra velocità e complessità quando ci sono elaborazioni maggiori.

Microsoft Copilot Studio – Essendo basato su Azure, beneficia delle prestazioni enterprise di Microsoft. In termini di tempo di risposta, i copiloti usano gli stessi endpoint di Azure OpenAI: GPT-4 impiega in genere qualche secondo per rispondere a prompt complessi, GPT-3.5 è molto rapido (sotto 1 secondo per risposte brevi). Copilot Studio aggiunge possibili step extra: ad esempio se l’agente deve cercare dati in tempo reale su SharePoint o interrogare Dynamics, ci sarà il tempo di query di quei sistemi. Microsoft però ha progettato Copilot per essere il più reattivo possibile: nel contesto M365 Copilot, promettono risposte rapide grazie a ottimizzazioni e caching nelle applicazioni Office. Per i custom copilot, non abbiamo numeri ufficiali, ma il fatto che vendano un pacchetto di 25k messaggi al mese suggerisce che immaginano un uso intensivo, quindi l’infrastruttura è tarata per reggere carichi elevati. Azure può scalare con più istanze del servizio se servono più throughput (con la modalità pay-as-you-go). Inoltre, Copilot Studio permette di pubblicare l’agente su Azure Regions di scelta, quindi un’azienda europea può ospitarlo in Europa per latenza minore. In generale, Microsoft ha molta esperienza nell’ottimizzare servizi cloud, quindi le performance sono affidabili. Un possibile collo di bottiglia è l’orchestrazione dei connettori: se un copilot deve concatenare molte azioni (es. 3 chiamate API diverse) la risposta finale attenderà la più lenta di esse. Ma questo succede solo per query molto complesse; per domande dirette l’LLM risponde immediatamente. Non risultano al momento dati pubblici su numeri di prestazioni (come numero di request al secondo supportate), ma possiamo presumere siano comparabili a un bot su Azure Bot Service, cioè in grado di servire migliaia di utenti concorrenti se scalato. Dunque, per l’utente finale, un copilot Microsoft apparirà abbastanza veloce, anche se forse leggermente meno scattante di un ChatGPT “vuoto” in casi in cui deve fare ricerche aggiuntive. AIsuru, avendo meccanismi di risposta ultra-rapida per certe query, potrebbe rispondere più velocemente a domande FAQ che Copilot demanderebbe al modello (es. “Qual è l’indirizzo dell’ufficio?” AIsuru potrebbe darlo all’istante da knowledge base). Ma la differenza è marginale in molti scenari.

Amazon Bedrock Agent Maker – Le prestazioni su AWS sono molto elevate e scalabili. Amazon Bedrock è pensato per gestire applicazioni mission-critical, e AWS dichiara che non serve preoccuparsi di provisioning, l’infrastruttura scala automaticamente (Automate tasks in your application using AI agents - Amazon Bedrock). In pratica, se un agente riceve molte richieste, AWS metterà a disposizione più capacità (fino ai limiti di throughput dell’account). I tempi di risposta dipendono, come sempre, dal modello e dalle azioni: modelli come Jurassic-2 o Claude 2 rispondono in pochi secondi per prompt medi, knowledge base search su AWS (che probabilmente utilizza Amazon Kendra o simili) è molto ottimizzata a livello di millisecondi. Inoltre, un grande vantaggio: se si prevede traffico sostenuto, si può usare la Provisioned Throughput per riservare capacità e garantire latenza costante anche sotto carico. Questo evita la variabilità o code di richieste. In condizioni normali, Bedrock agent risponde in tempo reale: ad esempio un agent che non fa azioni esterne fornirà risposte con latenza paragonabile a ChatGPT. Se invece deve effettuare chiamate API (es. eseguire un pagamento, ottenere dati esterni), la latenza include quelle operazioni – ma AWS Lambda e servizi interni possono spesso rispondere sub-secondo, quindi parliamo comunque di pochi secondi totali. AWS evidenzia anche la possibilità di monitorare le performance e vedere trace step-by-step (Automate tasks in your application using AI agents - Amazon Bedrock), così da ottimizzare eventuali colli di bottiglia. Questo livello di osservabilità aiuta a mantenere l’agente performante. Nel complesso, Bedrock offre prestazioni di livello enterprise: bassa latenza, alta capacità, possibilità di operare anche in modalità batch per throughput altissimi quando la latenza non è prioritaria. In un confronto con AIsuru: se entrambe usano ad esempio lo stesso modello Mistral 7B per rispondere a una domanda, i tempi dovrebbero essere simili; la differenza la fa l’ottimizzazione integrata – AIsuru con fastText può dare risposte immediate a certe domande già note, mentre Bedrock agent punterà sempre sul modello generativo a meno di caching custom. In scenari di altissimo carico (es. decine di richieste al secondo), AWS Bedrock ha il vantaggio di poter aumentare risorse illimitatamente (pagando il costo), mentre AIsuru essendo SaaS potrebbe avere dei limiti di rate. Tuttavia, per la maggior parte dei casi d’uso business, AIsuru regge bene il carico e AWS Bedrock è ampiamente sufficiente: entrambi forniscono risposte in tempi ragionevoli senza rallentamenti.

Capacità di personalizzazione

AIsuru – Offre un livello di personalizzazione molto elevato. Non è un singolo LLM, ma una piattaforma che può integrare diversi modelli linguistici esistenti (OpenAI GPT-3.5/GPT-4, Anthropic, Mistral, Google Gemini, modelli open source, ecc.). L’utente può scegliere il modello generativo preferito o collegare le proprie API key (ad esempio di OpenAI, Mistral o Anthropic) per usare un provider specifico. La piattaforma fornisce strumenti per plasmare la personalità e il comportamento del chatbot in modo semplice: ad esempio impostando istruzioni generali (anche con toni diversi: amichevole, formale, ecc.). Il training è no-code e può avvenire conversando direttamente con l’agent e correggendolo: AIsuru consente infatti di modificare le risposte sbagliate o indesiderate durante i test, affinché l'Agente AI apprenda immediatamente le correzioni. Inoltre supporta l’upload massivo di documenti, database, immagini, video e altri dati per arricchire la conoscenza del chatbot, con possibilità di integrazione via API a CMS esterni. Si possono anche definire intenti e funzioni custom (mini-applicazioni) per far eseguire azioni specifiche all’AI. In sintesi, AIsuru permette di costruire un assistente AI completamente su misura, dai dati su cui è addestrato fino all’integrazione in sistemi esterni, il tutto con sforzo ridotto (approccio extreme no-code dichiarato).

Lavoro PaaS di AIsuru per le aziende secondo Memori.ai

Dalla documentazione e dal sito Memori.ai, emerge chiaramente che AIsuru offre un'opzione Platform as a Service (PaaS) specificamente pensata per le aziende che desiderano una piattaforma AI brandizzata e completamente personalizzabile.

Cosa significa AIsuru come PaaS per le aziende?

- Piattaforma personalizzabile: le aziende possono accedere a un'istanza dedicata con il proprio logo, branding e configurazioni specifiche.

- Gestione completa degli utenti e dei dati: amministrazione autonoma delle chiavi API, utenti e impostazioni avanzate.

- Scalabilità e integrazione avanzata: connessione con CRM, ERP, email, ambienti VR e totem interattivi.

- Controllo totale sulle risposte e sui dati: possibilità di monitorare conversazioni, correggere risposte e garantire coerenza nei contenuti.

- Soluzione ideale per aziende con requisiti di sicurezza elevati: opzioni di private cloud, on-premise e conformità all’AI Act europeo.

Perché AIsuru PaaS è superiore?

AIsuru PaaS porta la personalizzazione e la gestione privata a un livello superiore, offrendo controllo totale sui propri modelli linguistici e personalizzazione avanzata dei contenuti grazie a strumenti come Retrieval-Augmented Generation (RAG), funzioni personalizzabili e widget programmabili di alto livello. Questo permette alle aziende di non dipendere da provider esterni per la gestione degli LLM e di mantenere la massima flessibilità operativa senza sacrificare la sicurezza e la privacy.

OpenAI GPTs – ChatGPT in versione Plus/Enterprise è ospitato sull’infrastruttura OpenAI (in Azure data center) e generalmente offre tempi di risposta rapidi, specialmente con GPT-3.5 Turbo (spesso <1 secondo per risposte brevi). GPT-4 è più lento, a volte impiega 5-10 secondi per una risposta complessa, semplicemente perché il modello è più pesante computazionalmente. OpenAI mette dei limiti di velocità per gli utenti (ad esempio, su Plus non si possono fare richieste in rapida sequenza illimitatamente, c’è un limite di ~50 richieste ogni 3 ore per GPT-4 come citato). Quindi per singolo utente l’esperienza è buona ma con un ritmo massimo. ChatGPT Enterprise ha rimosso alcuni limiti, permettendo prestazioni migliori per team. Però, se confrontato a soluzioni fatte per scalare su pubblico, ChatGPT “consumer” non è pensato per centinaia di utenti simultanei sulla stessa istanza – infatti OpenAI spinge chi deve fare un chatbot pubblico ad usare l’API. L’API OpenAI è molto veloce e scalabile (dietro c’è Microsoft Azure). Latenza media per GPT-3.5 è inferiore al secondo, per GPT-4 qualche secondo; c’è la possibilità di richieste in parallelo con throughput elevato, ma c’è anche una quota di rate limit (es. nuovi sviluppatori hanno tot token al minuto limitati). Si possono richiedere aumenti di quota pagando di più. Dunque, in un’app in produzione, usare OpenAI API permette buone prestazioni ma bisogna gestire il scaling manualmente (ad esempio implementare una coda, gestire i retry su errori di rate limit). Soluzioni come AIsuru/Copilot internalizzano questa gestione per l’utente finale. Dal punto di vista dell’utente finale che chatta con un GPT custom su ChatGPT, la velocità è la stessa di ChatGPT standard – ottima, con testo in streaming man mano che viene generato. AIsuru e altri offrono anch’essi lo streaming nelle chat integrate, quindi l’esperienza utente è paragonabile. Vale la pena notare che AIsuru menziona esplicitamente “alta velocità grazie a GPU dedicate” nell’offerta on-prem (What is Aisuru? | Memori AI), mentre OpenAI non permette ai clienti di avere il modello su GPU proprie (tranne alcuni casi via Azure). Ciò significa che se la velocità è critica e si vuole latenza sotto il mezzo secondo stabilmente, soluzioni custom come AIsuru on-prem possono battere un API cloud come OpenAI (niente hop di rete, inferenza locale). In generale però, OpenAI GPT (cloud) è molto performante e raramente la velocità di risposta è un problema per gli utenti, come dimostra il largo utilizzo di ChatGPT.

Sintesi: Tutte le piattaforme garantiscono tempi di risposta adeguati in tempo reale. AIsuru con il suo mix di NLP veloce e cloud scalabile offre risposte rapide e la possibilità di deployment locale per prestazioni massime. Copilot Studio eredita le performance Azure – solide, con possibili piccoli ritardi se coinvolge molti sistemi esterni. Bedrock è altamente ottimizzato e scalabile, adatto anche a carichi pesanti senza degrado (previa configurazione). OpenAI GPTs offre velocità eccellenti per singoli utenti e, via API, buone prestazioni per applicazioni scalate (richiedendo però gestione delle quote). In uno scenario di confronto, AIsuru non soffre di svantaggi prestazionali rispetto ai big, anzi la possibilità di tuning (on-prem, modelli custom) gli conferisce un notevole vantaggio per use case dove ogni millisecondo conta.

Sicurezza e privacy

AIsuru – Prodotto da una startup italiana (Memori) e progettato con attenzione alla privacy sin dall’inizio. AIsuru permette implementazioni on-premise in private cloud certificati grazie alla partnership con WIIT (provider cloud italiano) (Aisuru, che cos'è? | Memori AI). Ciò significa che i dati possono risiedere interamente in Italia, conformi GDPR, con sovranità completa dei dati per il cliente (Aisuru, che cos'è? | Memori AI). Questa è una caratteristica distintiva: le aziende che hanno requisiti GDPR forti o che operano in settori regolamentati possono usare AIsuru in un ambiente isolato, evitando il trasferimento di informazioni a server extra-UE. Anche nell’uso cloud standard su AWS, Memori specifica che la loro infrastruttura ha crittografia enterprise end-to-end dei dati sensibili e segregazione degli ambienti (Aisuru, che cos'è? | Memori AI). Sul sito, tra le feature Privacy, si citano cifratura end-to-end molto elevata e controllo granulare della condivisione dell'Agente (Professionisti | Memori AI). In pratica, i dati delle conversazioni e quelli caricati sono protetti e non vengono usati per addestrare modelli di terze parti senza consenso (essendo AIsuru un orchestratore, i modelli come GPT-4 vengono chiamati tramite le API dell’utente o di Memori e seguono le policy di quei servizi, ma AIsuru di per sé non “assorbe” i dati per altre finalità). Inoltre, AIsuru offre profilazione utente controllata – ad es. si può far rispondere l’AI diversamente in base al profilo utente (Professionisti | Memori AI), il che implica che il sistema può gestire dati personali in modo conforme alle scelte dell’utente e con regole programmabili. In termini di compliance, Memori essendo europea è soggetta direttamente a GDPR e presumibilmente fornisce DPA (Data Processing Agreement) ai clienti business. Il controllo totale sul flusso dati, anche grazie a eventuale hosting on-prem, rende AIsuru adatto a settori come finanza, sanità, PA dove la privacy è fondamentale (Aisuru, che cos'è? | Memori AI). Un altro aspetto sicurezza: AIsuru mantiene log e statistiche delle conversazioni per il proprietario dell'Agente (Professionisti | Memori AI), ma dà la possibilità di condividere l’AI solo con chi si vuole (anche tenerla completamente privata per test) (Professionisti | Memori AI). Questo evita accessi non autorizzati. In sintesi, AIsuru eccelle in sicurezza e privacy, offrendo controllo e trasparenza sui dati trattati e potendo operare in ambienti a elevata protezione (fino a soluzioni air-gapped con hardware dedicato) (What is Aisuru? | Memori AI).

Microsoft Copilot Studio – Microsoft ha messo la sicurezza al centro delle sue offerte Copilot, dato che si rivolgono a clienti enterprise spesso molto attenti a compliance. I dati aziendali rimangono all’interno del tenant Azure/M365 del cliente: le query ai modelli OpenAI di Azure non vengono usate per addestrare i modelli e sono trattate come dati confidenziali del cliente (Microsoft ha dichiarato che i prompt/risposte di Copilot non vengono letti da Microsoft né usati per migliorare l’AI, diversamente dall’uso di ChatGPT pubblico). Copilot Studio offre un centro di amministrazione dove l’IT può impostare policy DLP (Data Loss Prevention), controlli di accesso basati sui ruoli e monitorare le attività degli agenti (Customize Copilot and Create Agents | Microsoft Copilot Studio) (Building your own copilot with Copilot Studio | Microsoft Copilot Blog). L’integrazione con Microsoft Purview e Sentinel consente di auditare le conversazioni e ricevere alert su eventuali anomalie (Customize Copilot and Create Agents | Microsoft Copilot Studio). Questo livello di governance è importante: ad esempio un admin può impedire che il copilot risponda con certe informazioni riservate o loggare tutte le domande fatte. Dal punto di vista privacy, Microsoft è conforme a GDPR, con datacenter EU disponibili, e fornisce contratti con Clausole Modello UE e Data Processing Addendum standard. Hanno anche certificazioni di sicurezza (ISO 27001, SOC 2, ecc.) estese al servizio Copilot. Un aspetto rilevante: identità e accesso – i copiloti integrati in M365 usano l’identità Azure AD dell’utente, quindi le risposte possono essere personalizzate in base ai permessi dell’utente (es: se un dipendente non ha accesso a un file, il copilot non gliene rivelerà il contenuto). Questo rispetto dei permessi è un grande punto a favore in ambiente enterprise. AIsuru ha anch’esso la possibilità di profilare e modulare risposte per utente (Professionisti | Memori AI), ma Microsoft può sfruttare tutto lo stack di identità aziendale. In termini di robustezza, i sistemi Microsoft hanno protezioni contro attacchi noti (iniezioni di prompt, ecc., stanno continuamente aggiornando le guardrails). Anche Copilot Studio permette di definire “guardrail prompts” e regole per impedire all’AI di uscire dal seminato per i casi d’uso, aumentando la sicurezza nelle risposte (evitando che fornisca consigli errati in ambiti regolamentati, ad esempio). In conclusione, Microsoft offre un quadro di sicurezza e privacy di livello enterprise: dati segregati e criptati, conformità alle normative, controllo amministrativo completo. AIsuru, pur essendo più piccolo, raggiunge molti di questi obiettivi tramite l’architettura flessibile; Microsoft però ha già la fiducia di molte corporate per quanto riguarda tutela dei dati (contratti enterprise robusti).

Amazon Bedrock Agent Maker – AWS è anch’esso sinomino di sicurezza cloud. Amazon Bedrock aderisce ai principi AWS: nessun dato dei clienti viene utilizzato per addestrare modelli di terze parti e i dati in transito e a riposo sono cifrati. Chi crea un agente Bedrock può stare certo che le conversazioni e i prompt restano confinati nel proprio ambiente AWS. Amazon enfatizza che il servizio gestisce automaticamente crittografia e permessi utente per le chiamate API dell’agente (Automate tasks in your application using AI agents - Amazon Bedrock). Infatti, per configurare un agente occorre assegnargli un ruolo IAM con i permessi minimi per fare solo le azioni consentite (Create and configure agent manually - Amazon Bedrock) (Create and configure agent manually - Amazon Bedrock), implementando quindi il principio del minimo privilegio – questo è ottimo per sicurezza perché l’agente non potrà mai chiamare API non autorizzate o accedere a dati oltre il suo scopo. La compliance di AWS è ampia: certificazioni ISO, SOC, HIPAA, GDPR (con AWS si può scegliere region eu-west, ecc.). Per chi vuole extra sicurezza, AWS consente di mettere Bedrock in una VPC isolata, e con integrazione a AWS Secrets Manager le credenziali/API keys usate dall’agente per chiamare servizi esterni possono essere archiviate in modo sicuro. Inoltre, AWS ha strumenti come CloudTrail per loggare tutte le operazioni – incluso le azioni compiute dagli agenti – il che dà audit completo. In Bedrock è possibile impostare filtri di moderazione sulle risposte (ad esempio, usare Amazon Verify per contenuti inappropriati) per evitare output indesiderati. Un aspetto importante: lato modelli di terze parti (Anthropic, AI21…), AWS afferma di fungere da intermediario e che i prompt passati a questi modelli non vengono trattenuti dai provider. Ad esempio, i termini di Anthropic tramite Bedrock dovrebbero specificare che i dati sono usati solo per generare l’output e non per altro. Questo è un vantaggio rispetto a chiamare direttamente un’API esterna, perché AWS contrattualizza con quei provider. Nel complesso, Bedrock offre un ambiente molto sicuro per costruire agenti: è come sviluppare all’interno del proprio cloud privato, con controllo su reti, ruoli e crittografia. Lato privacy, i clienti mantengono la proprietà dei dati e AWS fornisce gli accordi GDPR necessari. Quindi su sicurezza/privacy AIsuru, MS e AWS sono tutti forti, con differenze sul modello di trust: AWS e MS sono grandi fornitori globali (alcune aziende UE potrebbero avere riserve per via del Cloud Act USA, sebbene mitigato da regole GDPR), mentre AIsuru essendo UE-native evita quel timore di trasferimento extra-UE. In pratica, per un’azienda italiana o europea pubblica, AIsuru può offrire maggior tranquillità giuridica (cloud italiano certificato (Aisuru, che cos'è? | Memori AI)), mentre AWS/Microsoft devono essere usati con le dovute valutazioni DPA/Clausole.

OpenAI GPTs – Sul fronte sicurezza e privacy, OpenAI ha fatto progressi, ma ci sono distinzioni tra uso consumer e enterprise. ChatGPT Plus (consumer): i dati inseriti dagli utenti possono essere utilizzati da OpenAI per addestrare e migliorare i modelli, a meno che l’utente disattivi la cronologia chat nelle impostazioni (Introducing GPTs | OpenAI) (funzionalità aggiunta di recente). Questo significa che se un dipendente usa ChatGPT Plus e vi incolla dati aziendali sensibili, rischia di condividerli involontariamente con OpenAI – scenario che ha portato molte aziende a vietare ChatGPT pubblico per lavoro. ChatGPT Enterprise/Team invece garantisce contrattualmente che nessun dato utente viene usato per training, e offre crittografia in transit e at rest di livello enterprise (ChatGPT Pricing | OpenAI). Inoltre, ChatGPT Enterprise è conforme a SOC 2 e OpenAI fornisce un Trust Portal con documenti di sicurezza (ChatGPT Pricing | OpenAI). Quindi, in modalità enterprise, la privacy è simile a quella di utilizzare Azure OpenAI (i dati restano privati). Tuttavia, attualmente OpenAI non offre opzioni di hosting dedicato on-prem o in un cloud privato del cliente: tutti i dati passano dai server OpenAI (principalmente negli USA). Per alcune aziende europee ciò è un ostacolo. Chi usa l’API OpenAI può comunque inserirla in un sistema che cripta end-to-end il contenuto (ad esempio, potrebbe cifrare i prompt prima di mandarli e decifrare le risposte, anche se questo limita l’utilità perché il modello deve “vedere” i dati in chiaro per elaborarli). In generale, usando l’API, OpenAI promette di non usare i dati per migliorare i modelli, quindi è relativamente sicuro, ma il cliente deve fidarsi del provider o mettere in atto misure supplementari. OpenAI ha annunciato certificazioni e impegni su GDPR in corso, ma essendo azienda USA senza infrastruttura EU locale (per ora), esistono sensibilità. Dal punto di vista della sicurezza delle risposte, OpenAI ha un sistema di moderazione robusto per ChatGPT (blocca output violenti, illegali, ecc.), e come creatore di GPT custom si possono impostare ulteriori vincoli (ad esempio “non rispondere su X se non presente nel documento”). Però non c’è un amministrative console sofisticata come Microsoft offre: per monitorare l’uso di un GPT custom condiviso bisognerebbe affidarsi agli strumenti di ChatGPT (che al momento sono basilari, es. vedere quante volte è stato usato). Dunque per un’azienda, OpenAI GPTs in sé è meno controllabile: o si passa a ChatGPT Enterprise (avendo però minima personalizzazione, poiché GPT custom è solo in Plus per ora) o si usa l’API in proprio (prendendosi cura di logging, audit, etc.). In sintesi: sul piano sicurezza informatica, i modelli OpenAI sono sicuri (in Azure hanno stesso livello di cifratura, in OpenAI cloud hanno team dedicato, bug bounty, etc. (ChatGPT Pricing | OpenAI)). Ma sul piano privacy e data governance, una soluzione come AIsuru offre maggiore rassicurazione locale e personalizzazione di policy, mentre con OpenAI si deve accettare le condizioni del fornitore e fidarsi che gestisca bene i dati (sebbene con Enterprise ci siano contratti forti).

Sintesi: AIsuru si distingue per un approccio privacy-first (sovranità dati, opzione on-prem, cifratura E2E) particolarmente adatto a realtà italiane/EU con requisiti GDPR stringenti (Aisuru, che cos'è? | Memori AI). Microsoft Copilot Studio e AWS Bedrock offrono anch’essi livelli altissimi di sicurezza, integrati nei loro ecosistemi (controlli di accesso, audit, compliance certifikata). La differenza sta nel controllo fine e nella giurisdizione: AIsuru permette di scegliere esattamente dove risiedono i dati (anche 100% in-house), mentre con Microsoft/AWS ci si affida a cloud pubblici conformi ma sempre soggetti a leggi extra-EU. OpenAI GPTs per uso professionale richiede il piano Enterprise o API con accordi adeguati; in mancanza, l’uso di ChatGPT pubblico è sconsigliabile con dati sensibili. In conclusione, AIsuru offre una tranquillità unica sul fronte privacy, unendo la potenza delle big tech con la riservatezza di un ambiente dedicato al cliente.

Supporto e comunità

AIsuru – Essendo un prodotto relativamente nuovo e specializzato, la comunità intorno ad AIsuru è in crescita ma più piccola rispetto a quella delle big tech. Tuttavia, i clienti AIsuru beneficiano di un supporto diretto e personalizzato da parte di Memori, la società creatrice. Memori offre assistenza clienti (sul sito forniscono email e contatti diretti del team) e tende a lavorare a stretto contatto con le aziende che adottano la piattaforma, anche fornendo demo e consulenza personalizzata (soprattutto per la versione Enterprise) (AIsuru - Subscriptions Plans). Inoltre, l’AIsuru AI Academy indica l’impegno a creare una community di utilizzatori esperti: attraverso i corsi, i professionisti possono imparare e connettersi con altri creatori di Agenti (What is Aisuru? | Memori AI) (What is Aisuru? | Memori AI). Memori pubblica case study e notizie sul blog (ad esempio, evidenziano progetti come Manuela 2.0 e hackathon vinti dal team (Blog | Memori AI), mostrando casi d’uso reali e successi della community). Essendo una realtà italiana, c’è il vantaggio del supporto in lingua italiana e della comprensione del contesto locale. Gli aggiornamenti della piattaforma sono continui (inclusi nel prezzo, come specificato) (Professionisti | Memori AI), e gli utenti vengono coinvolti nel miglioramento del prodotto – ad esempio invitandoli a dare suggerimenti (Professionisti | Memori AI). In assenza di una vasta community autonoma (forum pubblici etc. sono limitati, anche se potrebbe esistere un gruppo LinkedIn o simili), il valore sta nel supporto dedicato: Memori essendo una startup agile può fornire implementazioni custom, funzioni aggiuntive su richiesta (nel piano Enterprise parlano di “feature personalizzate” (AIsuru - Subscriptions Plans)) e tempi di risposta brevi alle segnalazioni. Per un’azienda cliente, questo significa avere un partner più che un semplice fornitore software. In confronto ai colossi, AIsuru ovviamente non ha milioni di utenti che discutono nei forum, ma ha un team motivato e focalizzato sulla riuscita dei progetti dei propri clienti.

Microsoft Copilot Studio – Qui il supporto rientra nel canale di supporto Microsoft per clienti enterprise e utenti Power Platform. Chi acquista Copilot Studio o ha licenze Microsoft 365 con Copilot ha diritto al supporto tecnico Microsoft (tipicamente via ticket, con tempi di risposta in base al livello di contratto – standard, Premier, etc.). Microsoft ha un enorme ecosistema di partner e integratori: ad esempio, società di consulenza IT già offrono servizi per implementare soluzioni con Copilot Studio (Generative AI Solutions with Microsoft Copilot Studio). Questo significa che un’azienda può facilmente trovare consulenti esterni certificati se vuole aiuto nel creare i propri agenti. La documentazione ufficiale è ricca (ci sono pagine su Microsoft Learn, quickstart, best practices (Master Autonomous AI Agents in Microsoft Copilot Studio - YouTube)) e in costante aggiornamento man mano che il prodotto evolve. La community di Power Platform e Azure AI è molto attiva: forum Microsoft Q&A, Tech Community blogs, stackoverflow tag, ecc., dove si possono porre domande e trovare risposte (già ora esistono thread su Copilot Studio e primi feedback degli utenti). Inoltre, eventi come Microsoft Ignite e Build includono sessioni su Copilot Studio, e Microsoft Learn potrebbe prevedere certificazioni su questa materia in futuro, il che allargherà la base di esperti. In termini di supporto linguistico, Microsoft offre documentazione in più lingue e supporto locale attraverso i suoi uffici globali, quindi anche supporto in italiano per clienti enterprise. Va notato che essendo Copilot Studio ancora abbastanza nuovo (annunciato fine 2023, in preview inizio 2024), la community deve ancora maturare appieno, ma considerando l’interesse per i copiloti, è probabile crescerà rapidamente. Comparando con AIsuru: Microsoft ha una community molto più vasta e strutturata, ma un singolo cliente può sentirsi uno tra tanti nella massa (a meno che non sia un cliente molto grande che riceve attenzione dedicata tramite Technical Account Manager). AIsuru invece offre un approccio boutique con supporto su misura. Dipende cosa si preferisce: con Microsoft c’è l’affidabilità di un gigante e una community che eventualmente produce tutorial, plugin, etc., mentre con AIsuru c’è la flessibilità di avere il team creatore a portata di mano.

Amazon Bedrock Agent Maker – Il supporto AWS è noto per essere tecnico e robusto. I clienti con piani di supporto Business o Enterprise AWS possono aprire casi su Bedrock come per qualsiasi servizio AWS e ricevere assistenza 24/7. AWS fornisce documentazione completa e approfondita (il Bedrock Developer Guide), sebbene molto tecnica. La community AWS (forums AWS re:Post, reddit, stackoverflow) già discute di Bedrock e di implementazione di agenti, ma essendo la feature relativamente nuova, le risorse community sono ancora limitate rispetto ad altri servizi AWS maturi. Comunque, AWS ha un programma di partner AI: integratori e ISV che possono aiutare a implementare Bedrock Agents nelle applicazioni enterprise. C’è anche del contenuto educativo: re:Invent 2023 ha avuto workshop su Bedrock Agents, e AWS spesso condivide esempi su GitHub (ad esempio un repository quickstart per Bedrock Agents (build-on-aws/amazon-bedrock-agents-quickstart - GitHub) (Building Custom Amazon Bedrock Agents for Automation from Scratch)). Un aspetto di supporto è la continuità del servizio: essendo AWS, la disponibilità del servizio è garantita da SLA e architetture ridondanti – c’è insomma fiducia che il servizio sia stabile e monitorato costantemente. Per la community, probabilmente vedremo crescere blogpost e video da sviluppatori che mostrano come integrare Bedrock Agents in vari scenari (già esistono video tutorial su YouTube (Building Custom Amazon Bedrock Agents for Automation from Scratch)). Tuttavia, di nuovo, il pubblico di riferimento è molto tecnico. Difficilmente un non-sviluppatore parteciperà a forum AWS su errori dell’agent; sarà lo sviluppatore dell’azienda a farlo. In parallelo, AIsuru cerca di abilitare anche figure non tecniche con la sua academy e community locale. In sintesi, con AWS si ha il supporto di un gigante cloud ma in modo impersonale (ticketing system, documenti, ecc.), e una community di sviluppatori cloud pronta ad aiutare sui dettagli implementativi. Un cliente AWS esistente troverà rassicurante poter gestire Bedrock Agents col solito supporto AWS.

OpenAI GPTs – Per utenti ChatGPT Plus, il supporto è limitato: c’è un help center e la possibilità di contattare il supporto OpenAI via form, ma le risposte possono richiedere tempo e spesso si fa affidamento sulla community online (OpenAI forum, Discord non ufficiali, Reddit) per dubbi o problemi comuni. OpenAI essendo stracolma di utenti non offre supporto diretto personalizzato ai singoli Plus user in modo approfondito. In ambito developer API, c’è una community di sviluppatori molto attiva: forum ufficiale, Stack Overflow, e miriadi di blog indipendenti. OpenAI pubblica esempi, ha una documentazione API ben fatta, e casi d’uso su Medium, ecc. Ma ancora una volta, questo presume che l’utente abbia capacità di auto-servirsi delle informazioni. ChatGPT Enterprise e i clienti API di grosso calibro invece ottengono canali di supporto dedicati (account manager, SLA di uptime, ecc.), ma ciò è riservato a contratti enterprise. Per la maggior parte delle aziende più piccole, usare direttamente OpenAI significa contare su self-service e risorse comunitarie. In confronto, AIsuru offre un hand-holding maggiore nel percorso. Un altro elemento: OpenAI GPTs essendo nuovo come concetto, non ha una “community di creatori di GPTs” consolidata (anche se si prevede un GPT Store dove le creazioni potranno essere condivise, generando magari una comunità simile all’App Store, ma è ancora agli inizi). Dunque, per ora chi crea un GPT custom non ha molti luoghi ufficiali dove discutere best practice specifiche (se non il forum OpenAI Developer dove questa feature è discussa in sezioni generali). Summarizzando: OpenAI ha dalla sua la vastissima community AI generica, quindi trovare esempi di prompt o integrazioni è facile, però manca un supporto strutturato diretto a meno di essere clienti enterprise. AIsuru essendo più di nicchia compensa con un supporto cliente proattivo.