Mai fidarsi di un'AI, gli LLM sono parolieri scaltri: un caso esplicativo

TL;DR: come un LLM può dire tutto e il contrario di tutto e quindi deve essere governato e indirizzato.

Chi sono:

Mi chiamo Nunzio Fiore, sono il CEO di Memori.ai, un'azienda che si occupa di intelligenze artificiali conversazionali e che ha prodotto una piattaforma SaaS e PaaS che permette a consumer e aziende di personalizzare e controllare le risposte di una AI conversazionale. Utilizziamo gli LLM per generare testo, ma implementiamo diverse strategie utili per controllare i contenuti.

Durante eventi e presentazioni ripeto spesso il concetto che gli LLM non hanno allucinazioni; è l'uso che ne facciamo a determinare il valore logico di verità o falsità di una frase. Ad esempio, la frase "il gigante è nella stanza" può essere falsa nella quotidianità, ma vera se sto scrivendo un racconto di favole. Pertanto, bisogna comprendere che la cosiddetta "allucinazione" è qualcosa che possiamo e dobbiamo controllare attraverso l'implementazione di varie strategie.

Gli LLM non fanno altro che mettere (al momento) una parola statisticamente probabile dopo l'altra. Si stanno conducendo ricerche per determinare una piccola frase statisticamente probabile, in modo da aumentare l'efficienza del modello stesso. Per quanto si lavori a migliorare questi metodi, sarà sempre necessaria la supervisione umana dei contenuti.

Il Caso

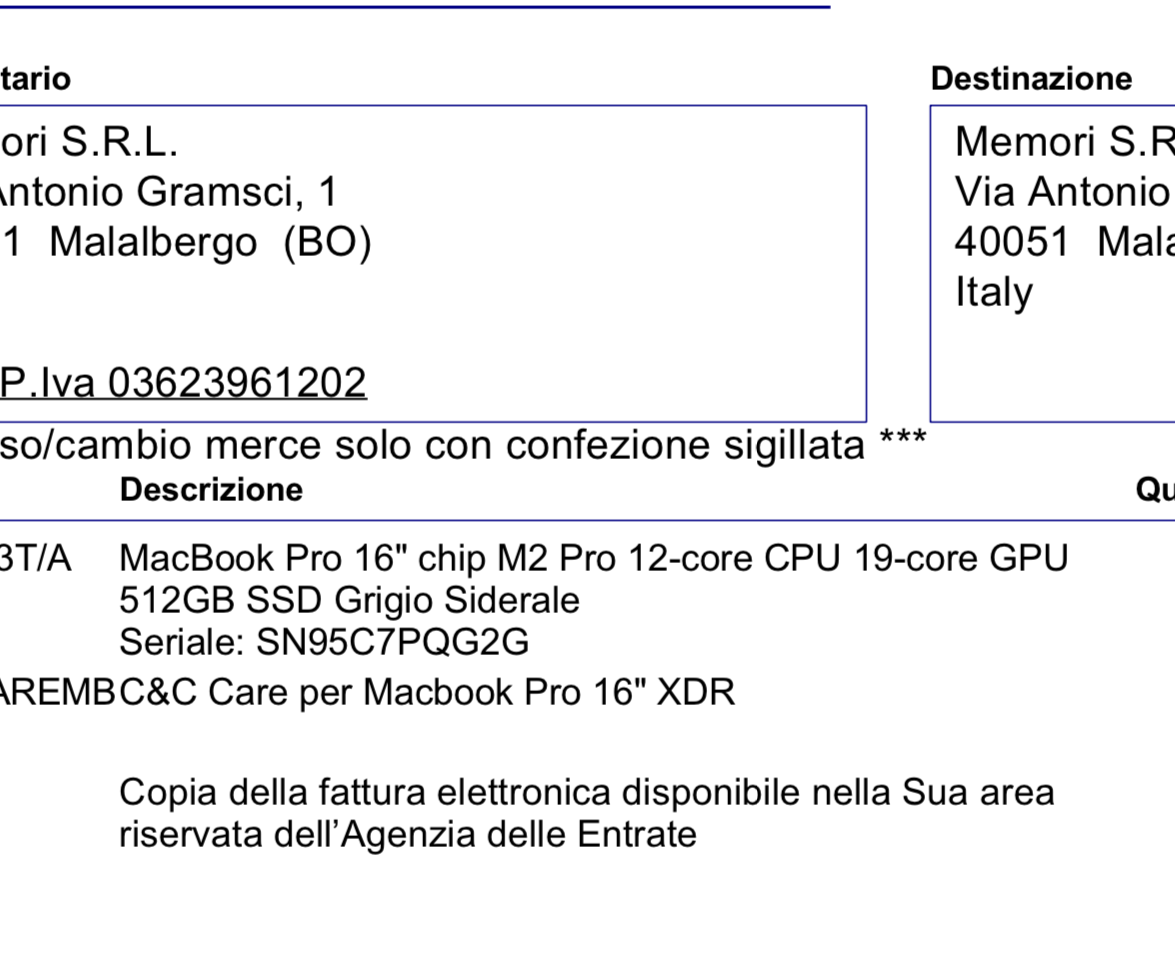

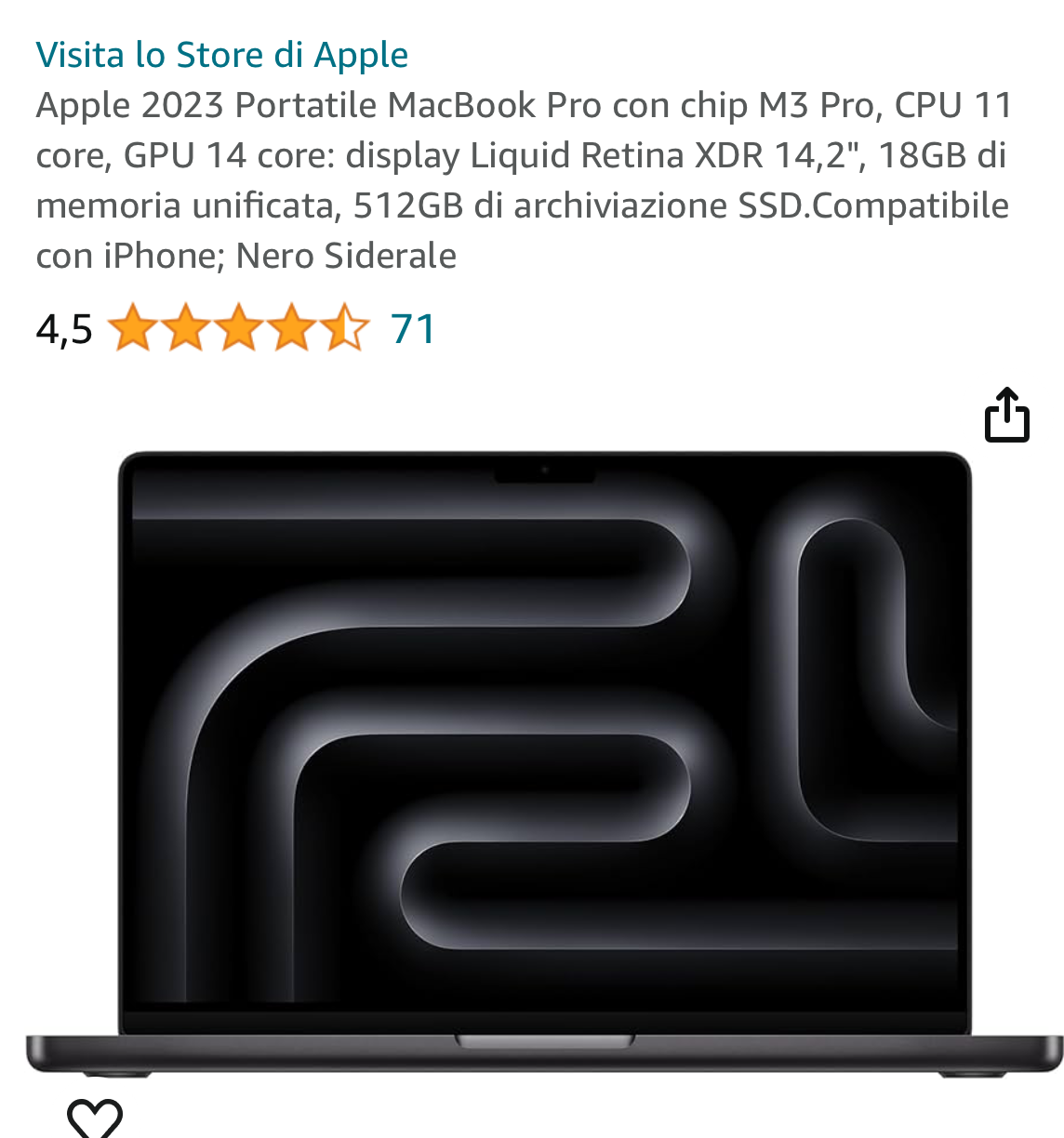

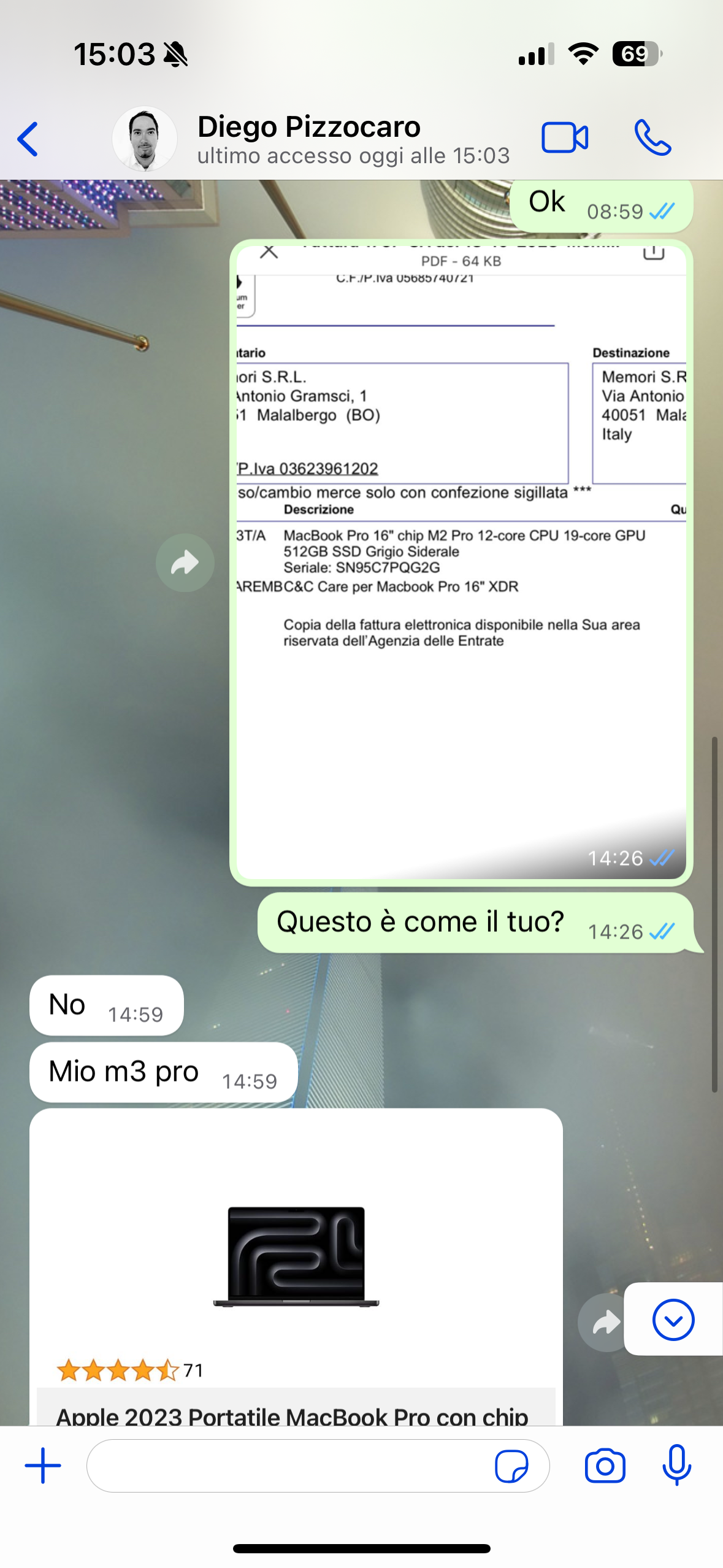

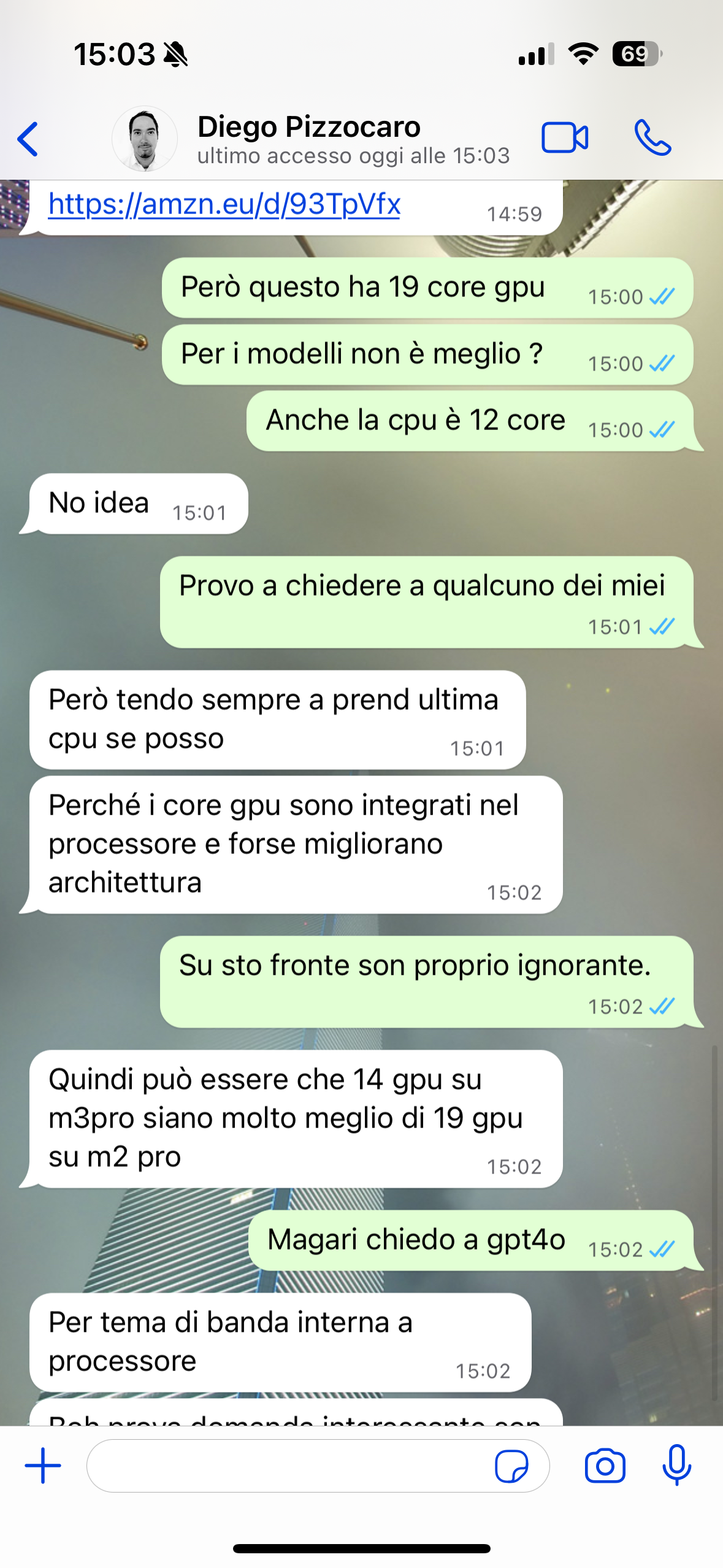

Per spiegare con un esempio pratico porto un caso reale. Ieri stavo facendo delle prove per addestrare un modello con delle mie foto per poter generare immagini per una rivista. Mi sono ritrovato davanti a un limite del mio attuale Mac, pertanto mi sono rivolto a un mio contatto, Diego Pizzocaro, che recentemente ha acquistato un nuovo MacBook con processore M3. Ci eravamo confrontati negli ultimi giorni proprio per valutare l'acquisto di un nuovo computer.

In azienda ho un MacBook con M2 che al momento non è utilizzato a pieno, quindi gli ho chiesto cosa ne pensasse e se potesse bastarmi l'M2 per i miei scopi. Dopo un breve scambio su WhatsApp, ho pensato di chiedere all'AI. Ecco cosa è successo:

Ho sfruttato il nuovo modello GPT-4o, che tra le altre cose sa leggere molto bene le immagini. Ho passato le quattro immagini: due che mostravano le caratteristiche dei due Mac e due che mostravano la chat avuta con Diego.

Queste le due immagini di chat con Diego:

Ho usato il seguente prompt:

“Io e Diego stiamo chiedendoci quale Mac sia meglio per usare Stable Diffusion e altri strumenti che necessitano di potenza e GPU per training e uso di modelli di intelligenza artificiale. Nelle immagini trovi le specifiche di due Mac che stiamo confrontando. Fai una ricerca e dacci la risposta come massimo esperto di AI e Mac.”

Qui la risposta:

For tasks involving AI models like Stable Diffusion that require significant computational power, especially in terms of GPU performance, the choice between the MacBook Pro M2 Pro and the M3 Pro is important. Here's a comparison based on your needs:

MacBook Pro M2 Pro (12-core CPU, 19-core GPU):

CPU and GPU: This model features a 12-core CPU and a 19-core GPU, offering robust performance for a variety of tasks including machine learning and AI training.

Memory and Bandwidth: The M2 Pro supports up to 32GB of unified memory with a memory bandwidth of 200GB/s, which is crucial for handling large datasets and training AI models efficiently.

Performance: The M2 Pro provides a 20% performance boost over the previous generation, making it well-suited for intensive computational tasks oai_citation:1,Apple MacBook Pro (2023) Review: M2 Pro and M2 Max Flex | Tom's Hardware oai_citation:2,Apple Releases M2 Pro and M2 Max: 20 Percent Faster, Up to 19 GPU Cores | Tom's Hardware.

MacBook Pro M3 Pro (11-core CPU, 14-core GPU):

CPU and GPU: The M3 Pro has an 11-core CPU and a 14-core GPU. Although it has fewer GPU cores than the M2 Pro, it benefits from architectural improvements and better energy efficiency due to the 3nm process technology.

Memory and Bandwidth: The M3 Pro supports up to 36GB of unified memory with a memory bandwidth of 153.6GB/s. While this is slightly less than the M2 Pro's bandwidth, the newer architecture often compensates with better performance per core.

Performance: Real-world benchmarks show that the M3 Pro can outperform the M2 Pro in specific tasks due to improved GPU performance and better memory handling oai_citation:3,Apple MacBook Pro (2023) Review: M2 Pro and M2 Max Flex | Tom's Hardware oai_citation:4,M3 Pro vs M2 Pro MacBook Pro 14” base models benchmarked | MacRumors Forums.

Key Considerations:

GPU Core Efficiency: Despite having fewer GPU cores, the M3 Pro's newer architecture can provide superior performance in some AI tasks, thanks to better ray tracing and memory allocation.

Power Consumption: The M3 Pro is more power-efficient, which can be advantageous for prolonged use and intensive tasks.

Overall Performance: Benchmarks indicate that the M3 Pro may offer better disk read speeds and slightly enhanced CPU and GPU performance in certain benchmarks, though the M2 Pro holds its ground well in other areas oai_citation:5,Apple MacBook Pro (2023) Review: M2 Pro and M2 Max Flex | Tom's Hardware oai_citation:6,M3 Pro vs M2 Pro MacBook Pro 14” base models benchmarked | MacRumors Forums.

Conclusion:

For AI and machine learning tasks, both models are highly capable. If you prioritize the latest technology and power efficiency, the M3 Pro might be the better choice. However, if you need more GPU cores and higher memory bandwidth, the M2 Pro remains a strong contender. Given the architectural advancements, the M3 Pro is generally a more forward-looking choice for future-proofing your investment.

For more specific benchmarks and real-world performance insights, you might want to consider reading detailed reviews and performance tests available on tech sites like Tom's Hardware and MacRumors.

Bene, fin qui ci siamo. Arriviamo allo scopo di questo articolo:

A questo punto ho girato la risposta a Diego, ma mi sono insospettito e ho pensato: proviamo a essere più razionali e ricordiamoci di ciò che dicevo all'inizio di questo articolo: "gli LLM sono parolieri". Gli LLM non sanno nulla. Non sanno nemmeno cosa stanno per dire. Non hanno un'idea di cosa vogliono dire e poi la dicono (noi in Memori con AIsuru lavoriamo proprio a questo invece, arrivare a fare avere all'AI un'idea di ciò che vuole dire prima di dirla, e abbiamo diversi cantieri e feature in merito, come ad esempio Pensiero Profondo). Pertanto, era chiaro che la chat con Diego avesse influenzato la risposta.

Ho quindi fatto il seguente test:

In una nuova chat (nuova perché altrimenti il modello sarebbe rimasto in contesto e avrebbe continuato con la sua risposta), ho passato solo le due immagini che parlano delle caratteristiche dei due Mac e poi ho posto lo stesso identico prompt di prima.

“Io e Diego stiamo chiedendoci quale Mac sia meglio per usare stable diffusion e altri strumenti che necessitano di potenza e gpu per training e uso di modelli di intelligenza artificiale .

Nelle immagini trovi le specifiche di due Mac che stiamo confrontando. Fai una ricerca e dacci la risposta come massimo esperto di ai e Mac “

A questo punto volevo verificare se l'AI avrebbe dato una risposta in linea con la precedente o meno. Questo il risultato:

Confrontiamo i due MacBook per l'uso di Stable Diffusion e altri strumenti di intelligenza artificiale, considerando le specifiche di ciascuno.

MacBook 1: Amazon.it (2023 MacBook Pro)

Chip: M3 Pro

CPU: 11-core

GPU: 14-core

Display: 14.2" Liquid Retina XDR

RAM: 18GB

Storage: 512GB SSD

Color: Nero Siderale

MacBook 2: Fattura (2023 MacBook Pro)

Chip: M2 Pro

CPU: 12-core

GPU: 19-core

Display: 16" XDR

Storage: 512GB SSD

Color: Grigio Siderale

Analisi Comparativa

Potenza di Calcolo e GPU

CPU:

M3 Pro: 11-core

M2 Pro: 12-core

Vincitore: M2 Pro (leggermente più potente)

GPU:

M3 Pro: 14-core

M2 Pro: 19-core

Vincitore: M2 Pro (significativamente più potente, essenziale per AI e deep learning)

Memoria e Archiviazione

RAM:

M3 Pro: 18GB

M2 Pro: Non specificato, ma tipicamente 16GB o 32

Vincitore: M3 Pro (se 18GB è superiore a quella del M2 Pro; altrimenti, M2 Pro con 32GB è migliore)

Storage: Entrambi 512GB SSD

Vincitore: Parità

Display:

M3 Pro: 14.2" Liquid Retina XDR

M2 Pro: 16" XDR

Vincitore: M2 Pro (display più grande e risoluzione migliore per visualizzare modelli AI complessi)

Conclusione

Per l'uso di Stable Diffusion e altri strumenti di intelligenza artificiale, il MacBook Pro con M2 Pro è generalmente una scelta migliore grazie alla CPU e GPU più potenti e al display più grande. Queste caratteristiche forniscono una maggiore capacità di calcolo e una migliore esperienza visiva, fondamentali per il training e l'uso di modelli AI avanzati.

Consiglio Finale

Optate per il MacBook Pro con M2 Pro se avete bisogno di massima potenza e capacità GPU per AI. Se il M3 Pro ha 18GB di RAM rispetto ai 16GB del M2 Pro, può essere un fattore da considerare, ma generalmente, la GPU più potente del M2 Pro è più vantaggiosa per i vostri scopi.

Come potete vedere, il risultato è stato diametralmente opposto. Da qui il titolo dell'articolo: "Mai fidarsi di un AI, gli LLM sono parolieri scaltri: un caso esplicativo" e il sottotitolo: "come può dire tutto e il contrario di tutto".

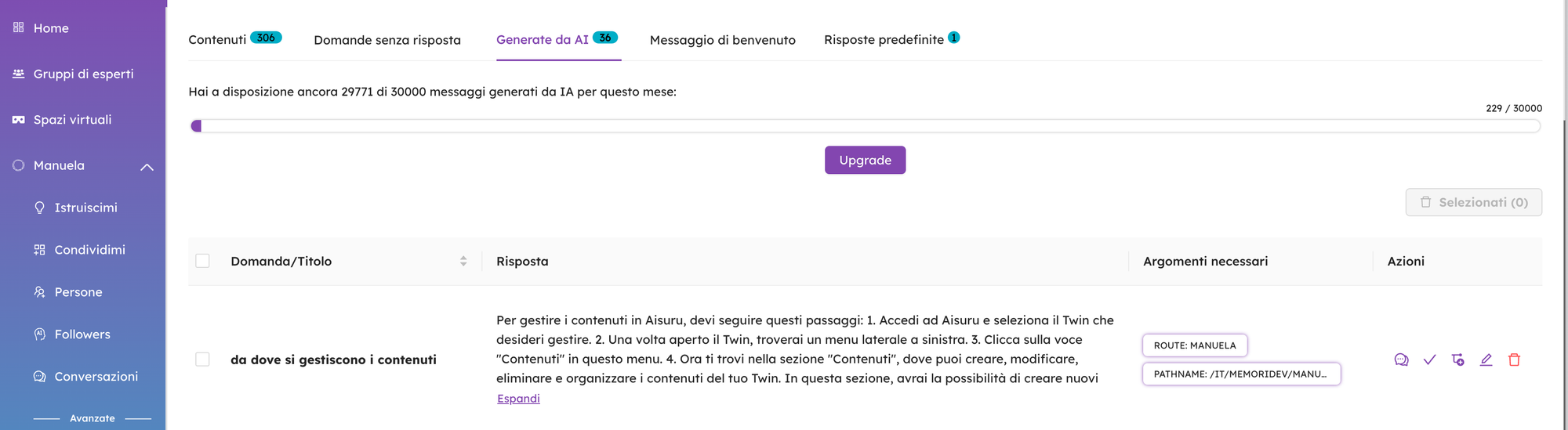

Con AIsuru è possibile personalizzare la risposta per luogo, per data, per persona che deve riceverla, per contesti e per contenuti.

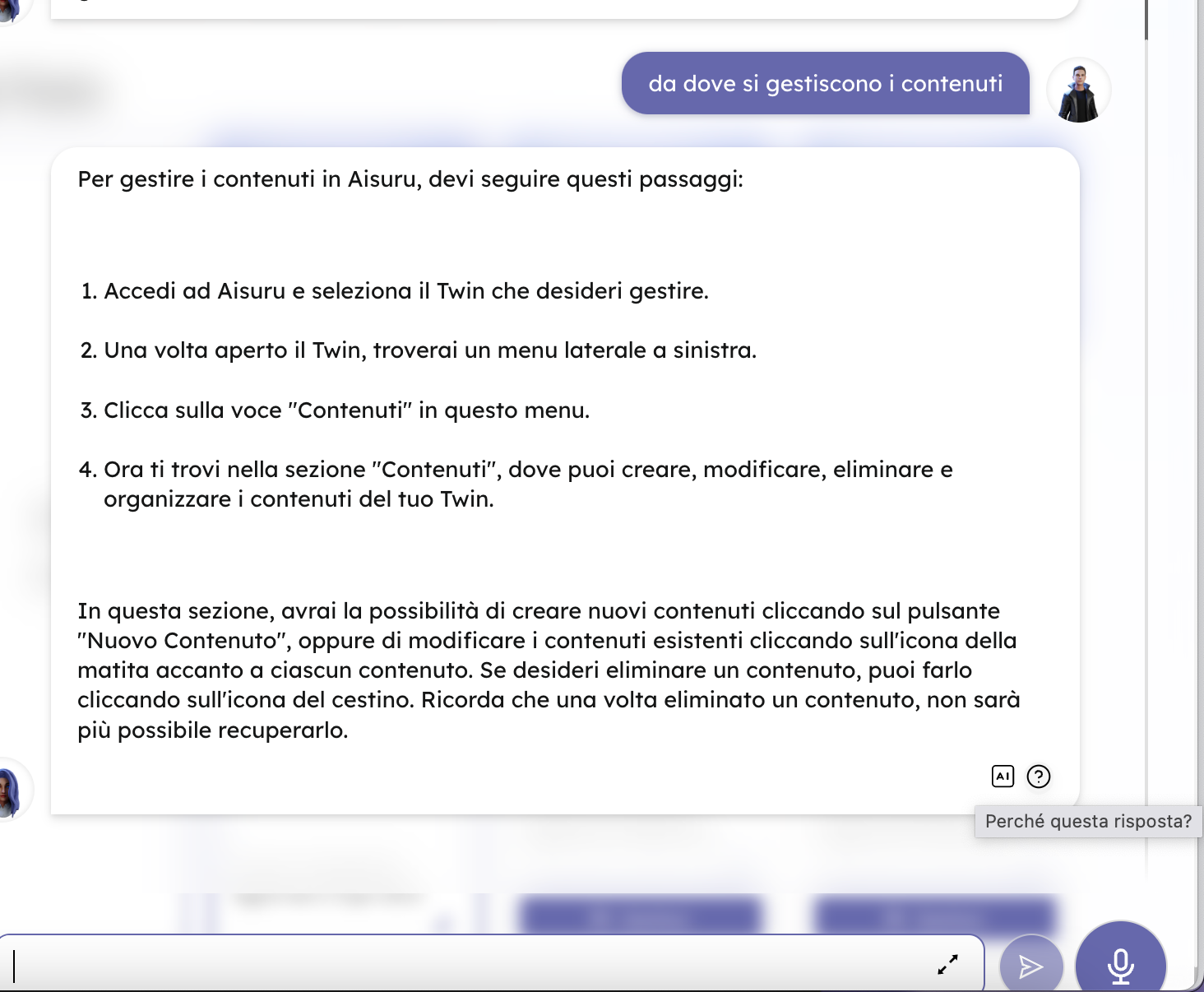

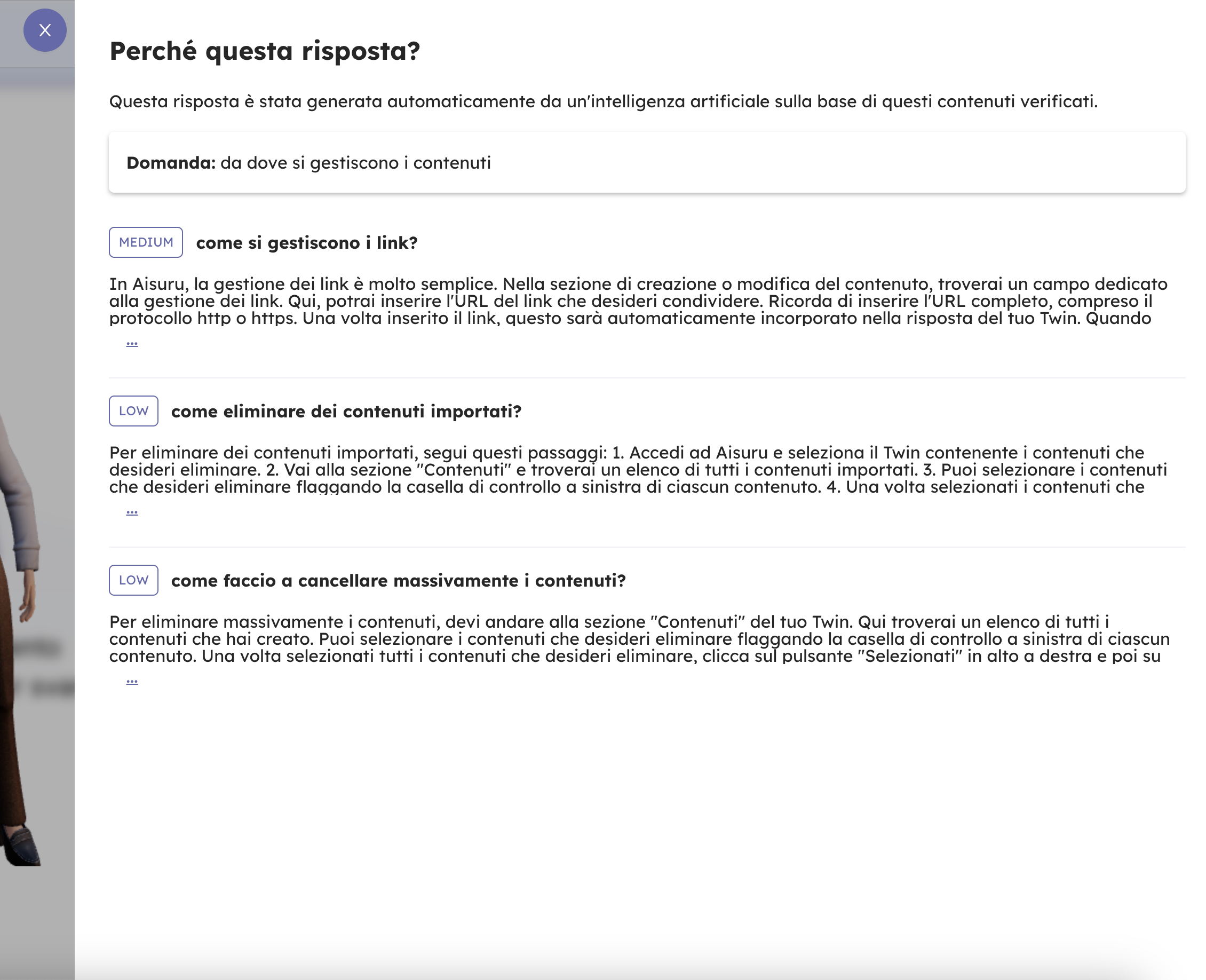

Questo comunque non basta, perché l'AI può comporre una risposta non valida. Per questo motivo abbiamo messo in atto diversi meccanismi che mostrano sia "perché questa risposta" è stata data a una domanda, sia strumenti ai creatori di una AI per mantenere i contenuti e validarli, modificarli, personalizzarli e arricchirli.

Le AI non possono essere create e rilasciate senza pensare che debbano essere mantenute. Per noi in Memori le AI sono un nuovo media di trasmissione della conoscenza e come tale deve essere monitorato e mantenuto.

L’utilizzo che noi e i clienti devono farne non è quello di avere risposte ma quello di fargli dire ciò che vogliamo.

Spero che questo articolo aiuti a comprendere meglio il vero potenziale degli LLM. Non sono le risposte che ci danno se non supervisionate, ma i client, i software e le strategie che attuiamo per governarli che fanno la differenza e li trasformano in strumenti realmente utili.